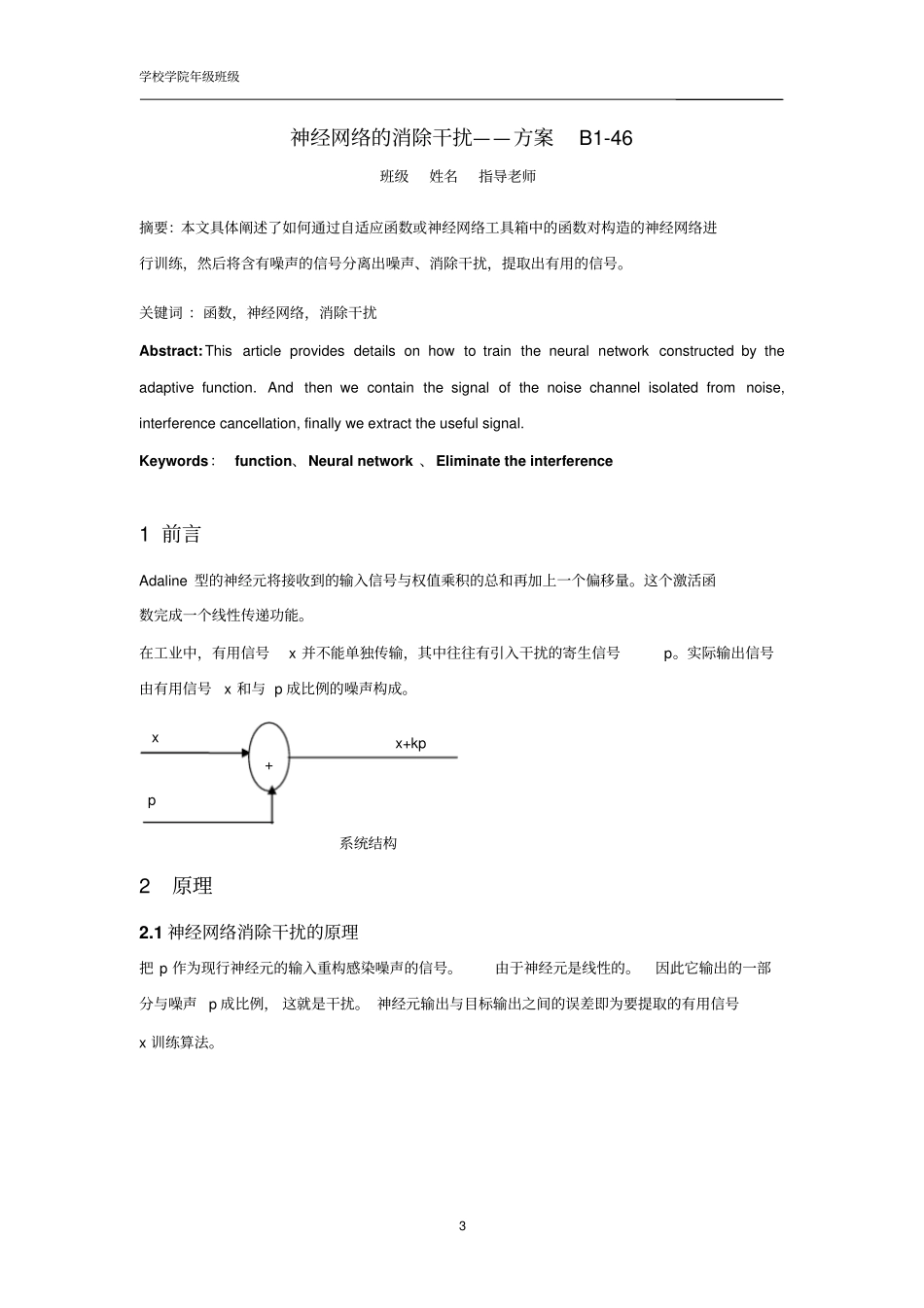

测控系统课程设计题目:神经网络的消除干扰——方案B1-46院(系)专业学号姓名级别指导老师2012年6月Huaqiaouniversity学校学院年级班级2目录1.前言2.原理2.1神经网络消除干扰的原理2.2adaptwh函数2.3learnwh函数2.4程序中用到的训练算法原理3.程序、注释、结果3.1.1程序1与注释3.1.2程序1结果3.2.1程序2与注释3.2.2程序2结果4.程序分析5.程序小结6.课设心得7.参考文献学校学院年级班级3神经网络的消除干扰——方案B1-46班级姓名指导老师摘要:本文具体阐述了如何通过自适应函数或神经网络工具箱中的函数对构造的神经网络进行训练,然后将含有噪声的信号分离出噪声、消除干扰,提取出有用的信号。关键词:函数,神经网络,消除干扰Abstract:Thisarticleprovidesdetailsonhowtotraintheneuralnetworkconstructedbytheadaptivefunction.Andthenwecontainthesignalofthenoisechannelisolatedfromnoise,interferencecancellation,finallyweextracttheusefulsignal.Keywords:function、Neuralnetwork、Eliminatetheinterference1前言Adaline型的神经元将接收到的输入信号与权值乘积的总和再加上一个偏移量。这个激活函数完成一个线性传递功能。在工业中,有用信号x并不能单独传输,其中往往有引入干扰的寄生信号p。实际输出信号由有用信号x和与p成比例的噪声构成。2原理2.1神经网络消除干扰的原理把p作为现行神经元的输入重构感染噪声的信号。由于神经元是线性的。因此它输出的一部分与噪声p成比例,这就是干扰。神经元输出与目标输出之间的误差即为要提取的有用信号x训练算法。xp+x+kp系统结构学校学院年级班级4例如,在一个噪声较大的环境中打电话,如车间、机场等,想要传输最接近于有用信号x的信号,这时已知整个信号,可以用如下自适应函数:[y,c,w,b]=adaptwh[w,b,x,t,eta]2.2adaptwh函数函数使用格式[a,e,w,b]=adaptwh(w,b,p,t,lr)%ADAPTWHWidrow-霍夫规则相适应的线性层.%使用NNT2LIN和ADAPT更新和适应网络%[A,E,W,B]=ADAPTWH(W,B,P,T,lr)%W-SxR权重矩阵%B-Sx1偏置向量%P-RXQ输入向量矩阵%T-目标向量SxQ矩阵%lr-学习率(可选,默认值=0.1)。%返回:%A-自适应线性滤波器的输出%E-自适应线性滤波器的误差%W-新的权重矩阵%B-新的偏置向量.%如果nargin<4,错误(“NNET:参数','没有足够的论据”),结束%训练参数ifnargin==4,lr=0.1;end[r,q]=size(p);[s,q]=size(t);a=zeros(s,q);e=zeros(s,q);%呈报期fori=1:qa(:,i)=purelin(w*p(:,i),b);e(:,i)=t(:,i)-a(:,i);[dw,db]=learnwh(p(:,i),e(:,i),lr);w=w+dw;b=b+db;pbWp+by-+t=x+kpx线性神经元系统结构学校学院年级班级5End2.3learnwh函数[dw,ls]=learnwh(w,p,z,n,a,t,e,gW,gA,d,lp,ls)%LEARNWHWidrow霍夫重量/偏见的学习功能。%句法%[dW,LS]=learnwh(W,P,Z,N,A,T,E,gW,gA,D,LP,LS)%[db,LS]=learnwh(b,ones(1,Q),Z,N,A,T,E,gW,gA,D,LP,LS)%info=learnwh(code)%描述%LEARNWH是Widrow-的霍夫重量/偏置学习功能,%也是最小平方(LMS)原则%LEARNWH(W,P,Z,N,A,T,E,gW,gA,D,LP,LS)需要多个输入%W-SxR偏重矩阵(或b是SX1偏置的载体)%P-RxQi输入向量(或(1,Q)).%Z-SxQ加权输入向量.%N-SxQ净输入向量。%A-SxQ输出向量。%T-SxQ层目标向量。%E-SxQ层误差向量。%gW-SxR梯度方面的表现。%gA-SxQ输出梯度方面的性能。%D-SxS神经元的距离。%LP-学习参数,无,LP=[].%LS-学习状态,最初应该是=[]。%返回%dW-SxR偏重(或偏置)的变化矩阵.%LS-新的学习状态%学习是根据LEARNWH的学习参数,%这里显示其默认值。%LP.lr-0.01-学习率%LEARNWH(CODE)返回每个CODE串的有用信息:%'pnames'-学习参数返回名称.%'pdefaults'-返回默认学习参数.%'needg'-返回1,如果此功能使用gW或GA.%举例%在这里,我们定义一个随机输入P和误差E层%与2元的输入和3个神经元。我们还定义了%学习率LR的学习参数。%p=rand(2,1);%e=rand(3,1);%lp.lr=0.5;%由于LEARNWH只需要这些值来计算权重的变化(见下面的算法),%dW=learnwh([],p,[],[],[],[],e,[],[],[],lp,[])学校学院年级班级6%NetworkUse%你可以创建一个标准的网络使用LEARNWH纽林。%要准备的偏重和层的一个自定义的...