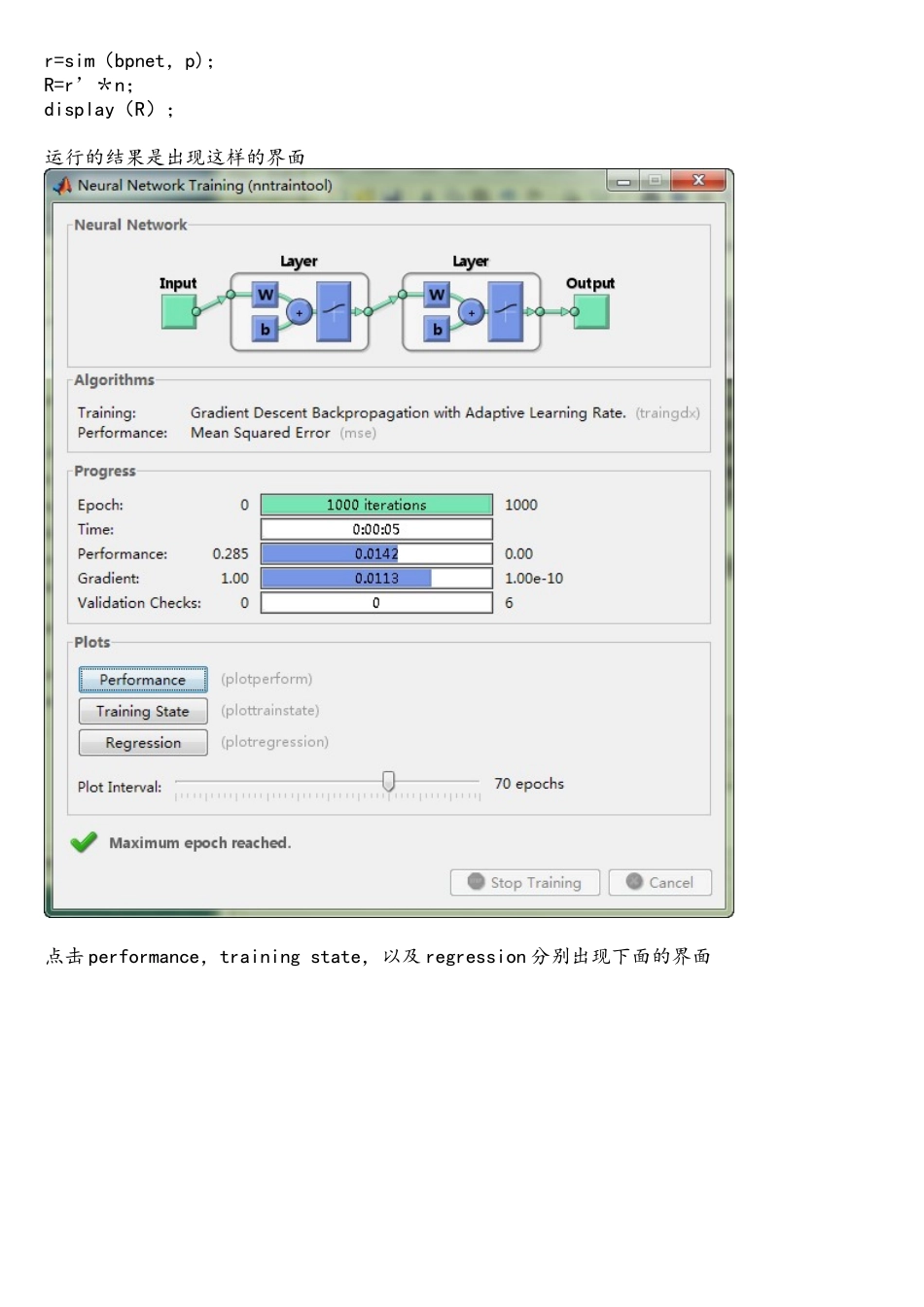

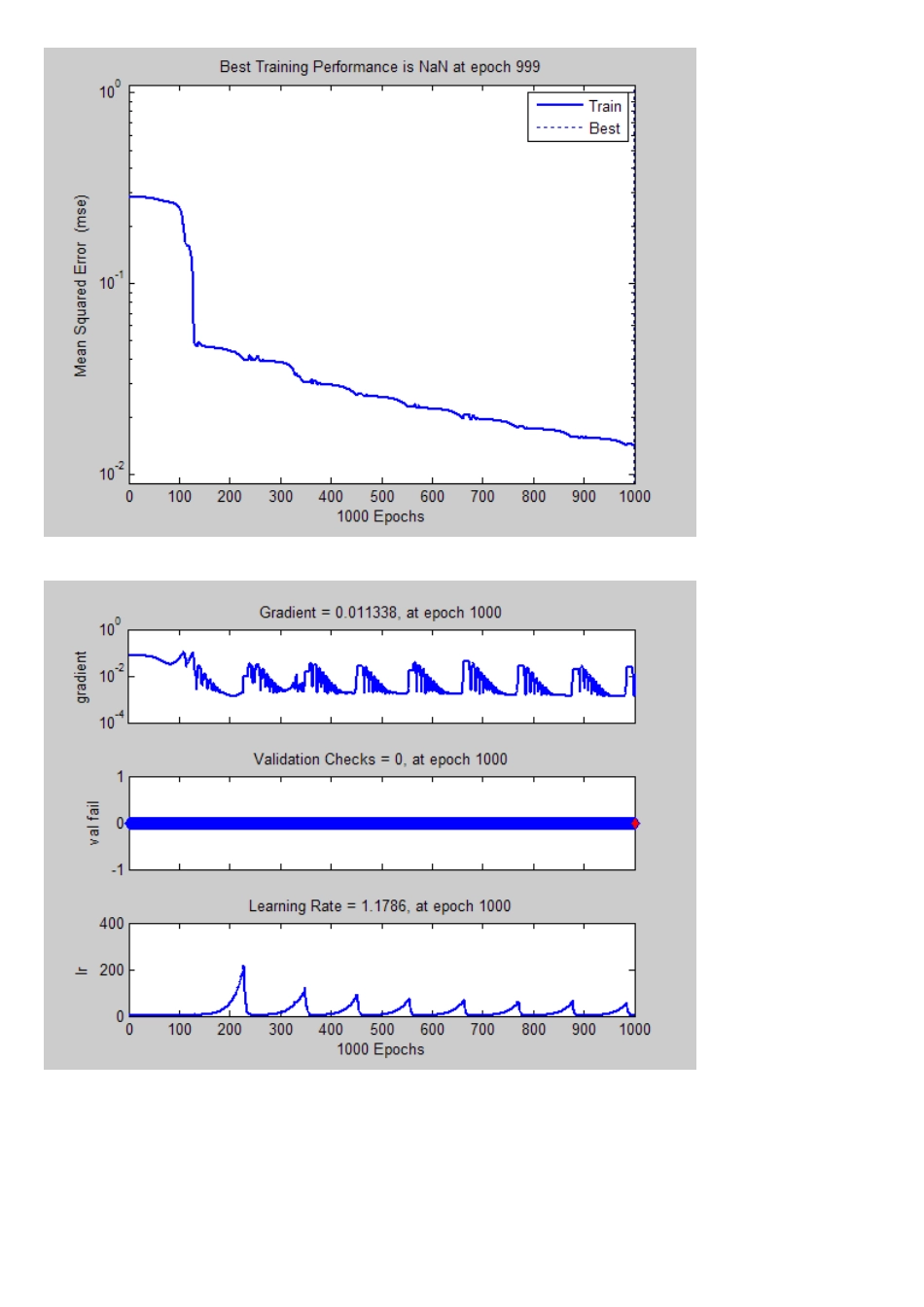

为了看懂师兄的文章中使用的方法,讨论了一下神经网络昨天花了一天的时间查怎么写程序,但是费了半天劲,不能运行,百度知道里倒是有一个,可以运行的,先贴着做标本% 生成训练样本集clear all;clc;P=[110 0.807 240 0。2 15 1 18 2 1.5;110 2。865 240 0.1 15 2 12 1 2;110 2。59 240 0。1 12 4 24 1 1.5;220 0。6 240 0。3 12 3 18 2 1;220 3 240 0。3 25 3 21 1 1。5;110 1。562 240 0.3 15 3 18 1 1。5;110 0.547 240 0。3 15 1 9 2 1。5];0 1.318 300 0.1 15 2 18 1 2];T=[54248 162787 168380 314797;28614 63958 69637 82898;86002 402710 644415 328084;230802 445102 362823 335913;60257 127892 76753 73541;34615 93532 80762 110049;56783 172907 164548 144040];@907 117437 120368 130179];m=max(max(P));n=max(max(T));P=P'/m;T=T'/n;%—-———--—-——————-—-—--———-—-———------—---—-———--—----———-———-—--———--—--——%pr(1:9,1)=0; %输入矢量的取值范围矩阵pr(1:9,2)=1;bpnet=newff(pr,[12 4],{'logsig', ’logsig’}, ’traingdx’, ’learngdm’);%建立 BP 神经网络, 12 个隐层神经元,4 个输出神经元%tranferFcn 属性 'logsig’ 隐层采纳 Sigmoid 传输函数%tranferFcn 属性 ’logsig' 输出层采纳 Sigmoid 传输函数%trainFcn 属性 'traingdx' 自适应调整学习速率附加动量因子梯度下降反向传播算法训练函数%learn 属性 'learngdm’ 附加动量因子的梯度下降学习函数 net.trainParam。epochs=1000;%允许最大训练步数 2000 步net.trainParam.goal=0.001; %训练目标最小误差 0.001net.trainParam.show=10; %每间隔 100 步显示一次训练结果net。trainParam.lr=0。05; %学习速率 0.05bpnet=train(bpnet,P,T);%——————--------——--—--—-——-——-—--——--————---——----——----———-——-———--——---—p=[110 1.318 300 0。1 15 2 18 1 2];p=p’/m;r=sim(bpnet,p);R=r’*n;display(R);运行的结果是出现这样的界面点击 performance,training state,以及 regression 分别出现下面的界面再搜索,发现可以通过神经网络工具箱来创建神经网络,比较友好的 GUI 界面,在输入命令里面...