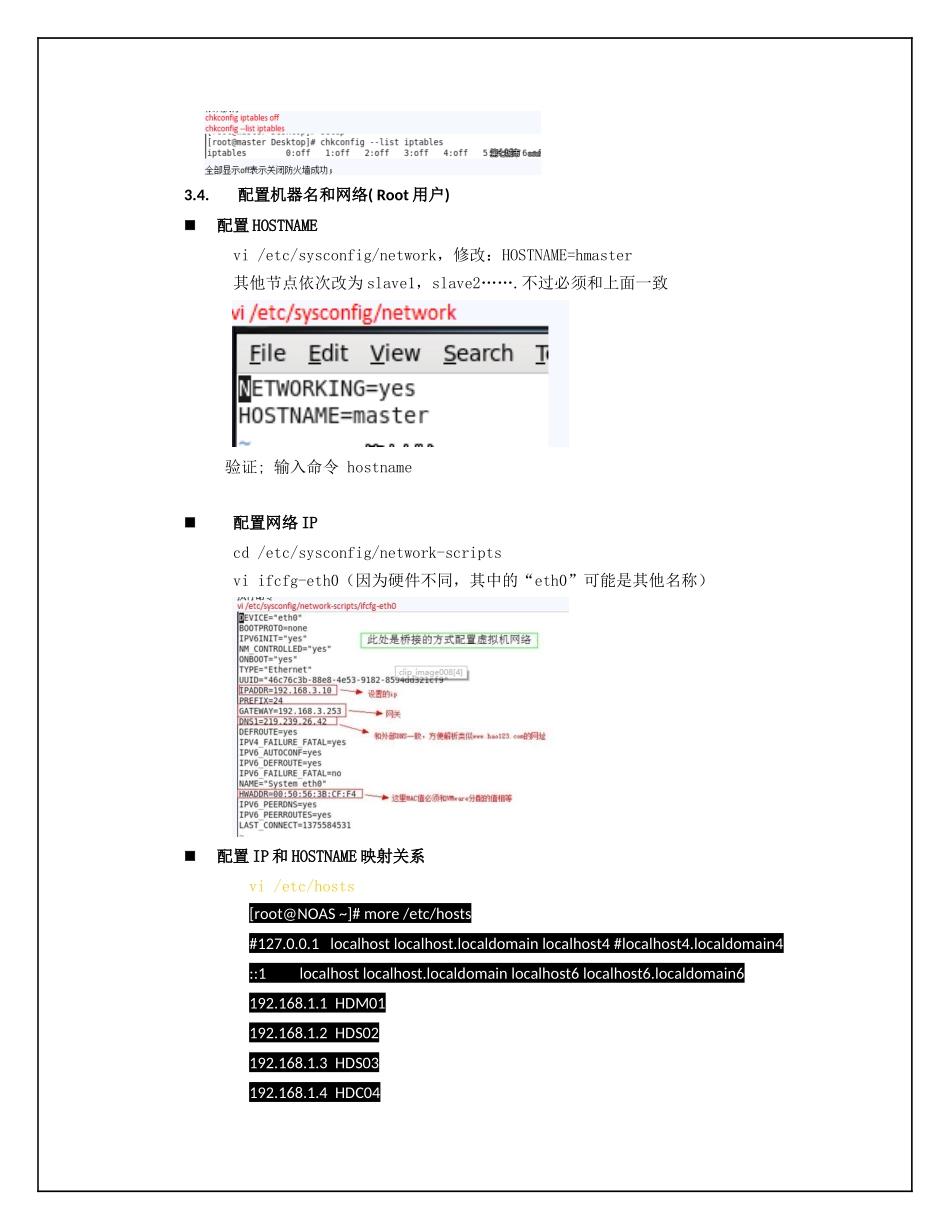

安装HADOOP集群服务器1.规划功能HOSTNAMEIP说明MasterHDM01192.168.1.1Namenode兼datanodeSlaveHDS02192.168.1.2DatanodeSlaveHDS03192.168.1.3DatanodeClientHDC04192.168.1.4HADOOP客户端(HDFS/HIVE)2.环境2.1.系统环境安装centOS6.2=>软件工作站(softwareDevelopmentWorkstation)3.Hadoop安装3.1.安装和配置SSH、RSYNC(Root用户)安装SSH和rsync一般系统自带了;3.2.创建Hadoop运行用户(Root用户)一般我们不会经常使用root用户运行hadoop,所以要创建一个平常运行和管理Hadoop的用户;创建hadoop用户和用户组useraddhadoopPS:master和slave节点机都要创建相同的用户和用户组,即在所有集群服务器上都要建hadoop用户和用户组。3.3.关闭防火墙(Root用户)在启动前关闭集群中所有机器的防火墙,不然会出现datanode开后又自动关闭。所以对集群所有服务器关闭防火墙:chkconfigiptablesoff查看防火墙状态:serviceiptablesstatus永久关闭防火墙:chkconfigiptablesoff查看防火墙状态:chkconfig--listiptables3.4.配置机器名和网络(Root用户)配置HOSTNAMEvi/etc/sysconfig/network,修改:HOSTNAME=hmaster其他节点依次改为slave1,slave2…….不过必须和上面一致验证;输入命令hostname配置网络IPcd/etc/sysconfig/network-scriptsviifcfg-eth0(因为硬件不同,其中的“eth0”可能是其他名称)配置IP和HOSTNAME映射关系vi/etc/hosts[root@NOAS~]#more/etc/hosts#127.0.0.1localhostlocalhost.localdomainlocalhost4#localhost4.localdomain4::1localhostlocalhost.localdomainlocalhost6localhost6.localdomain6192.168.1.1HDM01192.168.1.2HDS02192.168.1.3HDS03192.168.1.4HDC043.5.配置非root用户免验证登录SSH(hadoop用户)提示:Linux配置ssh是通过欺骗登录用户名的。所以上面创建用户的时候,我们都把3个节点的username都设置成hadoop,主要是用户名必须一致在hadoop用户的home目录,即cd/home/hadoop下执行命令用hadoop用户登录(第一/二/三步分别在每一个节点上都要执行)第一步:ssh-keygen-trsa-P''-f~/.ssh/id_rsa意思是读取id_dsa文件默认全部是yes安装和root用户一样,会发现多处2个文件,一个是公开密匙,一个是访问用户名字信息的第二步:cat~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys是把暴露出来的公共密匙按顺序导入authorized_keys中保存第三步:chmod700~/.sshchmod600~/.ssh/authorized_keysssh机制很严谨,对文件的权限要求非常严格我们需要把.ssh文件夹的权限改为700,默认是777authorized_keys的权限这里是对的,600第四步:在主节点上执行下列命令sshHDS02cat~/.ssh/id_rsa.pub>>~/.ssh/authorized_keyssshHDS03cat~/.ssh/id_rsa.pub>>~/.ssh/authorized_keysscpauthorized_keyshadoop@HDS02:/home/hadoop/.ssh/scpauthorized_keyshadoop@HDS03:/home/hadoop/.ssh/最终authorized_keys文件要有各个集群服务器的信息第五步:验证第一次会要求输入密码,完成后测试,每台机都要求能联通:sshHDM01sshHDS02sshHDS03不输入密码就表示成功了;3.6.安装JDK(hadoop用户)检查是否已安装JDK:rpm-qa|grepjdk检查JAVA安装目录:whickjava检查是否配置JAVA_HOME:env|grepJAVA_HOMEwhichjava和JAVA_HOME路径不一致,是做了LINK映射[root@NOAS~]#su-hadoop[hadoop@NOAS~]$rpm-qa|grepjdkjava-1.6.0-openjdk-javadoc-1.6.0.0-1.41.1.10.4.el6.x86_64java-1.6.0-openjdk-devel-1.6.0.0-1.41.1.10.4.el6.x86_64java-1.6.0-openjdk-1.6.0.0-1.41.1.10.4.el6.x86_64[hadoop@NOAS~]$whichjava/usr/bin/java[hadoop@NOAS~]$ls-l/usr/bin/javalrwxrwxrwx.1rootroot22Feb2622:26/usr/bin/java->/etc/alternatives/java[hadoop@NOAS~]$ls-l/etc/alternatives/javalrwxrwxrwx.1rootroot46Feb2622:26/etc/alternatives/java->/usr/lib/jvm/jre-1.6.0-openjdk.x86_64/bin/java[hadoop@NOAS~]$env|grepJAVA_HOMEJAVA_HOME=/usr/lib/jvm/jre-1.6.0-openjdk.x86_64在当前用户配置JAVA_HOME,在.bash_profile文件增加蓝色部分,最后source/home/hadoop/.bash_profile,使生效hadoo...