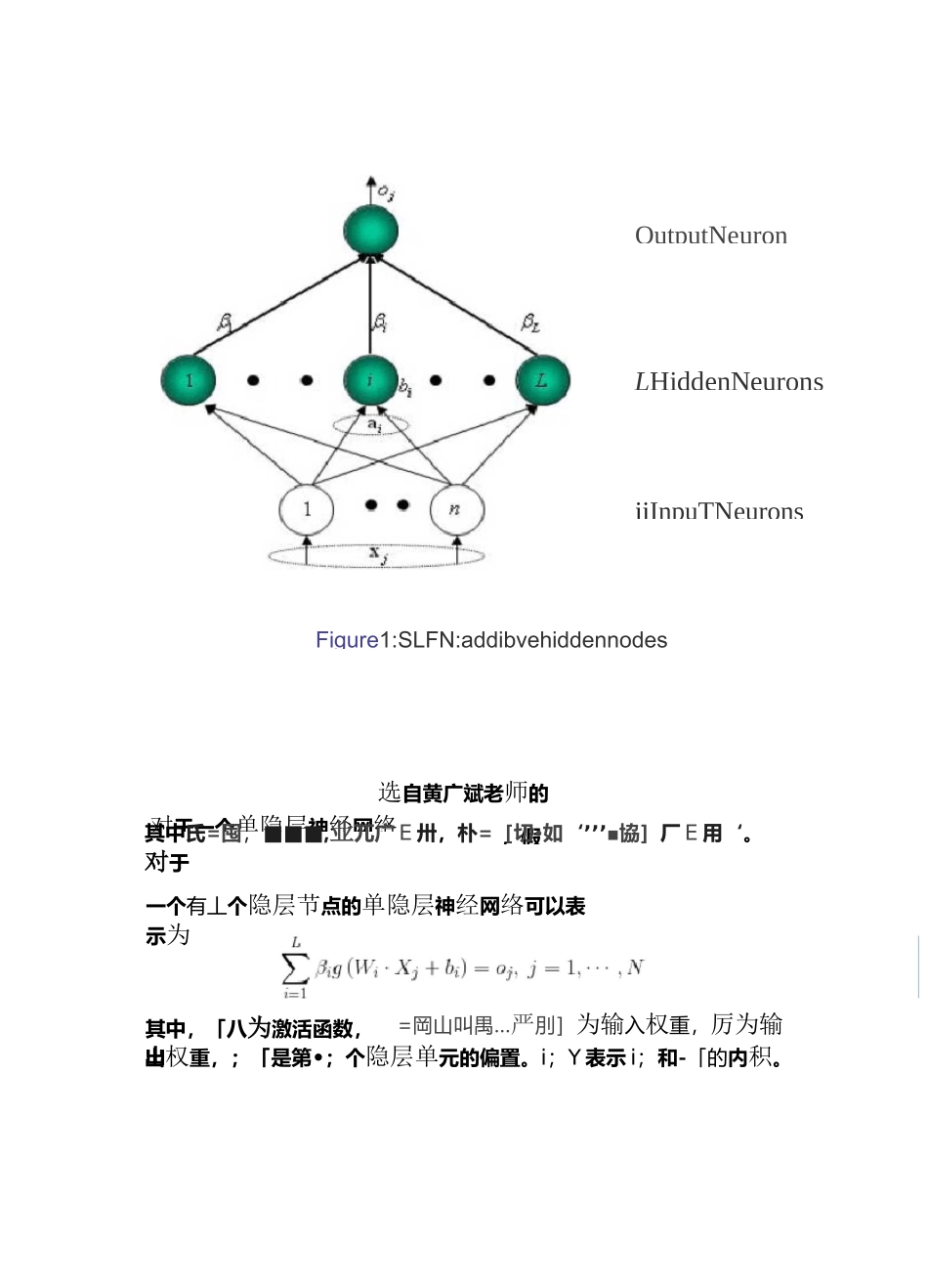

简单易学的机器学习算法限学习机极限学习机的概念极限学习机,是由黄广斌提出来的求解单隐层神经网络的算法最大的特点是对于传统的神经网络,尤其是单隐层前馈神经网络,在保证学习精度的前提下比传统的学习算法速度更快。二、极限学习机的原理是一种新型的快速学习算法,对于单隐层神经网络,可以随机初始化输入权重和偏置并得到相应的输出权重。OutputNeuronLHiddenNeuronsiiInpuTNeurons对于一个单隐层神经网络,假选自黄广斌老师的其中氏=囤,■■■,业兀广E卅,朴=[切•如‘’’’■協]厂E用‘。对于出权重,;「是第•;个隐层单元的偏置。i;Y表示i;和-「的内积。Figure1:SLFN:addibvehiddennodes一个有丄个隐层节点的单隐层神经网络可以表示为其中,「八为激活函数,山=岡山叫禺…严刖]为输入权重,厉为输单隐层神经网络学习的目标是使得输出的误差最小,可以表示为”冋-圳=0戸1即存在,i;和「,使得工阳阿'冷+帕=轴7=1,"L,AT=1可以矩阵表示为H,.i=T|其中,打是隐层节点的输出,为输出权重,广为期望输出。■-,Vn^b■-■虹•%[・・・・为了能够训练单隐层神经网络,我们希望得到I1/,'和,使得其中,丨-■<,这等价于最小化损失函数E=工(工两㈣•兀+如—订>1\!=1/传统的一些基于梯度下降法的算法,可以用来求解这样的问题,但是基本的基于梯度的学习算法需要在迭代的过程中调整所有参数。而在算法中一旦输入权重i;和隐层的偏置八被随机确定,隐层的输出矩阵"就被唯一确定。训练单隐层神经网络可以转化为求解一个线性系统/。并且输出权重可以被确定j=HrT[plain]viewplaincopy广其中,"是矩阵打的数是最小的并且唯一。三、实验原始数据集我们采用统计错误率的方式来评价实验的效果,其中错误率公式为:NumErrorerrorRatt-=NumAll对于这样一个简单的问题,「:‘“,;1I'O代码我们使用《简单易学的机器学习算法,回归》中的实验数据。[plain]viewplaincopy主程序%%主函数,二分类问题%导入数据集A=load('testSet.txt');data=A(:,1:2);%特征label=A(:,3);%标签[N,n]=size(data);L=100;%隐层节点个数m=2;%要分的类别数%--初始化权重和偏置矩阵W=rand(n,L)*2-1;b_1=rand(1,L);ind=ones(N,1);b=b_1(ind,:);%扩充成N*L的矩阵tempH=data*W+b;H=g(tempH);%得到H%对输出做处理temp_T=zeros(N,m);fori=1:Niflabel(i,:)==0temp_T(i,1)=1;elsetemp_T(i,2)=1;endendT=temp_T*2-1;outputWeight=pinv(H)*T;%--画出图形x_1=data(:,1);x_2=data(:,2);holdonfori=1:Niflabel(i,:)==0plot(x_1(i,:),x_2(i,:),'.g');else1.2.3.4.5.6.7.8.9.10.11.12.13.14.15.16.17.18.19.20.21.22.23.24.25.26.27.28.29.30.31.32.33.34.35.36.37.38.39.40.41.42.43.44.plot(x_1(i,:),x_2(i,:),'.r');45.end46.end47.47.output=H*outputWeight;48.%——计算错误率49.tempCorrect=0;50.fori=1:N51.[maxNum,index]=max(output(i,:));52.index=index-1;53.ifindex==label(i,:);54.tempCorrect=tempCorrect+1;55.end56.end58.57.errorRate=1-tempCorrect./N;激活函数[plain]viewplaincopy1.function[H]=g(X)2.H=1./(1+exp(-X));3.endmachine:anewlearningschemeoffeedforwardneuralnetworks】。与SVM,传统神经网络相比,ELM的训练速度非常快,需要人工干扰较少,对于异质的数据集其泛化能力很强。Huang在【Extremelearningmachines:asurvey,2011】这篇论文中对ELM进行了总结,包括最初的ELM算法和后来被发展延伸的ELM算法(比如在线序列ELM算法、增量ELM算法和集成ELM算法等),里面的很多知识点值得学习。ELM的原理从神经网络的结构上来看,ELM是一个简单的SLFN,SLFN示意图如下:该SLFN包括三层:输入层、隐含层和输出层(忽略输入层则为两层)。其中隐含层包括L个隐含神经元,一般情况下L远小于N,输出层的输出为m维的向量,对于二分类问题,显然该向量是一维的。对于一个训练数据样本,忽略输入层和隐含层而只考虑隐含层神经元的输出和输出层,则神表示第i个隐含层神经元和输出神经元之间的连接权值,即它是一个m维的权值向量。公式里面的G是隐含层神经元的输出。针对加法型隐含层节点,G为:G(际如罠)=X...