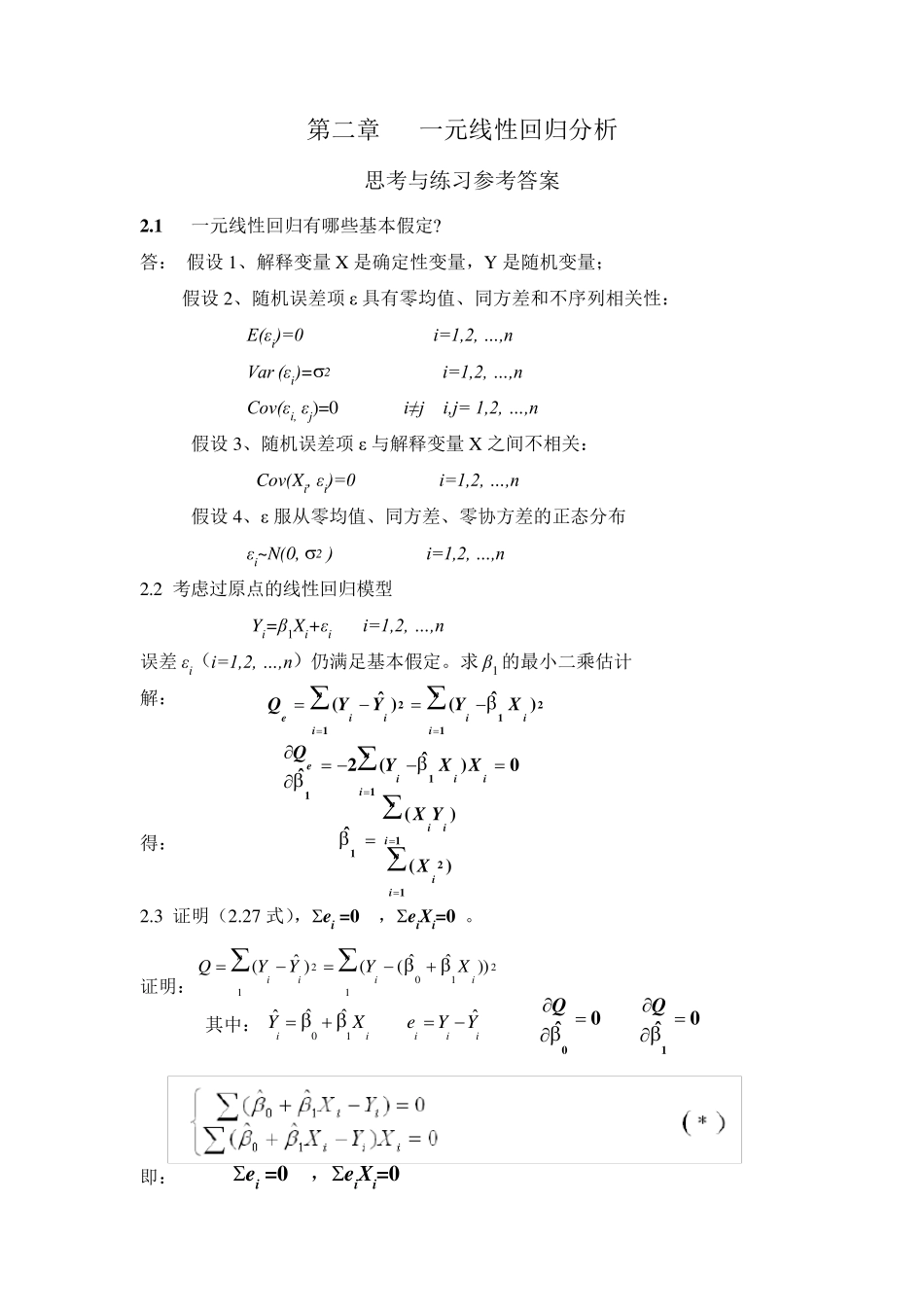

第二章 一元线性回归分析 思考与练习参考答案 2.1 一元线性回归有哪些基本假定? 答: 假设1、解释变量 X 是确定性变量,Y 是随机变量; 假设2、随机误差项 ε 具有零均值、同方差和不序列相关性: E(εi)=0 i=1,2, …,n Var (εi)=2 i=1,2, …,n Cov(εi, εj)=0 i≠j i,j= 1,2, …,n 假设3、随机误差项 ε 与解释变量 X 之间不相关: Cov(Xi, εi)=0 i=1,2, …,n 假设4、ε 服从零均值、同方差、零协方差的正态分布 εi~N(0, 2 ) i=1,2, …,n 2.2 考虑过原点的线性回归模型 Yi=β1Xi+εi i=1,2, …,n 误差 εi(i=1,2, …,n)仍满足基本假定。求 β1 的最小二乘估计 解: 得: 2.3 证明(2.27 式),ei =0 ,eiXi=0 。 证明: 其中: 即: ei =0 ,eiXi=0 niiiniXYYYQ121021))ˆˆ(()ˆ(21112)ˆ()ˆ(iniiniiieXYYYQ0)ˆ(2ˆ111iiniieXXYQ)()(ˆ1211niiniiiXYX01ˆˆˆˆiiiiiYXeYY0100ˆˆQQ2.4 回归方程E(Y)=β0+β1X 的参数β0,β1 的最小二乘估计与最大似然估计在什么条件下等价?给出证明。 答:由于εi~N(0, 2 ) i=1,2, …,n 所以 Yi=β0 + β1Xi + εi~N(β0+β1Xi , 2 ) 最大似然函数: 使得 Ln(L)最大的0ˆ ,1ˆ 就是 β0,β1 的最大似然估计值。 同时发现使得 Ln(L)最大就是使得下式最小, 上式恰好就是最小二乘估计的目标函数相同。值得注意的是:最大似然估计是在εi~N(0, 2 )的假设下求得,最小二乘估计则不要求分布假设。 所以在εi~N(0, 2 ) 的条件下, 参数β0,β1 的最小二乘估计与最大似然估计等价。 2.5 证明0ˆ 是 β0 的无偏估计。 证明:)1[)ˆ()ˆ(1110niixxiniiYLXXXYnEXYEE )] )(1([])1([1011iixxiniixxiniXLXXXnEYLXXXnE 01010)()1(])1([ixxiniixxiniELXXXnLXXXnE2.6 证明 证明: )] ()1([])1([)ˆ(102110iixxiniixxiniXVarLXXXnYLXXXnVarVar niiiniXYYYQ121021))ˆˆ(()ˆ()1()1()ˆ(2221220xxniiLXnXXXnVar})],([21exp{)2()(),,(2010122/21210iininiiniXYYfL...