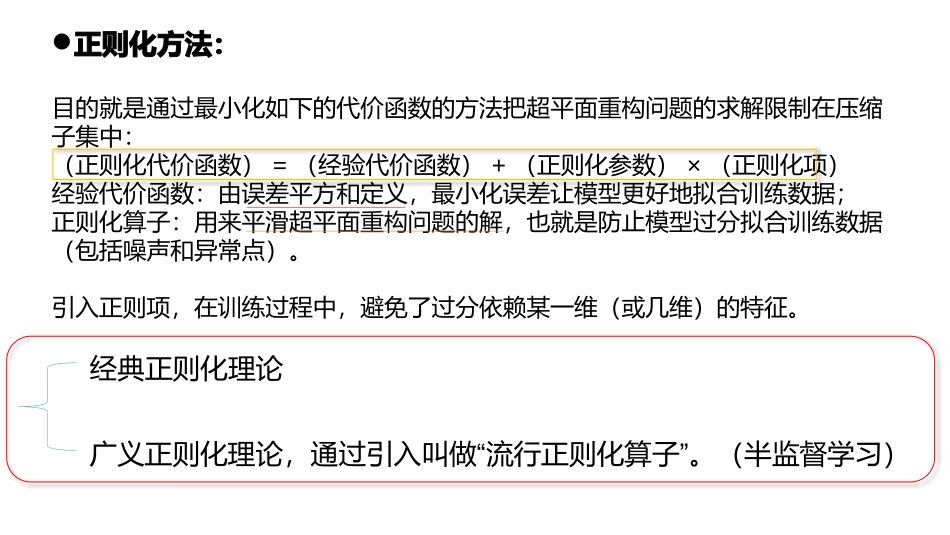

第7章正则化理论1、正则化基础2、良态及病态问题3、Tikhonov正则化理论4、广义径向基函数网络5、再论正则化最小二乘估计6、正则化参数估计7、半监督学习8、广义正则化理论9、光谱图理论10、拉普拉斯正则化最小二乘算法【1正则化基础】监督学习算法共同点:通过样本训练网络,对于给定的输入模式给出输出模式,等价于构造一个超平面,也就是多维映射。为了得到一条好的超平面,通常都是根据训练数据,利用最小化误差来使得更好地得到一条超平面,但是训练误差小不是我们的最终目标,我们的目标是希望模型的测试误差小,也就是能够准确地预测新的样本。但是,往往当参数太多的情况下,会导致模型复杂度上升,当在追求尽可能小的误差时就容易过拟合,过拟合从直观上理解就是在对训练数据进行拟合时,要照顾到每个点(相关特征与无关特征),从而使得拟合函数波动性非常大。那我们就希望模型“简单”一些,在这个基础上最小化训练误差,这样得到的参数才具有较好的泛化性能。这里模型的“简单”就是通过正则化函数来实现的。正则化方法:目的就是通过最小化如下的代价函数的方法把超平面重构问题的求解限制在压缩子集中:(正则化代价函数)=(经验代价函数)+(正则化参数)×(正则化项)经验代价函数:由误差平方和定义,最小化误差让模型更好地拟合训练数据;正则化算子:用来平滑超平面重构问题的解,也就是防止模型过分拟合训练数据(包括噪声和异常点)。引入正则项,在训练过程中,避免了过分依赖某一维(或几维)的特征。经典正则化理论广义正则化理论,通过引入叫做“”流行正则化算子。(半监督学习)【2病态良态问题】如果一个学习问题不具有连续性,则所计算的输入输出映射与学习问题的准确解无关。病态问题:上述三个条件中的任何一个都不满足(过拟合情况的发生)。要解决这些困难就必须附加先验知识。【3Tikhonov正则化理论】正则化的基本思想就是通过某些含有解的先验信息的非负的辅助泛函来使解稳定。Tikhonov的正则化理论包含两项:最小化标准误差项约束条件•当正则化参数趋近0时无约束,泛函最小点解完全由样本确定,即有很大不确定性。•当正则化参数趋近∞时,正则化项占支配地位,微分算子D施加的先验光滑约束对求解泛函最小点是充分的,此时样本是不可靠的。•正则化参数应取在这两个极限条件之间的某个值,这样训练样本和先验知识都能对求解泛函最小点起作用。复杂度罚函数模型Tikhonov泛函的Frechet微分:进行代价泛函的最小化,则它的Frechet微分可以解释为一个最佳局部线性逼近。(下面都是为求泛函最小值Fλ(X)做的工作)(式7.2)引入Riesz表示定理:表示H空间上两个函数的内积式(7.7)重写为:1>除了零点以外的点都等于02>在整个定义域上的积分等于1其作用类似于转置矩阵只有当满足时,(7.13)式才为0为了求Fλ(x)做准备代表展开系数,与系统估计误差呈线性关系,与正则化参数成反比。确定展开系数令:(7.23)(7.22)(7.24)(7.31)(7.32)联立式(7.30)和(7.31)得:实际上,总将正则化参数取足够大,使得正定的,从而是可逆的,则有唯一解G是对称的正则化逼近函数:训练样本长度线性加权和输入数据点数m=N,且输入向量xi与Green函数G(x,xi)(i=1,2,…,N)之间是一一对应关系。【4广义径向基函数网络】降低复杂度后在一个较低维的空间中得到一个次优解,来逼近式(7.36)的正则化解。这里可以通过利用称为Galerkin方法的标准技术实现,得到一个近似解:≈典型情况下,这组新的基函数的个数小于输入数据点的个数,即m1≤N(7.48)一组新的基函数:(7.49)G为N×m1阶,不对称将式(7.51)右边第二项写成如下形式:(7.55)G0为对称阵以权值向量w为变量求式(7.51)的最小值,得到则:(7.57)•广义RBF网络与正则化RBF网络比较【5再论正则化最小二乘估计】指出:式(7.57)包括正则化最小二乘估计,并且最小二乘估计看作该式的一个特例。逼近(7.63)和(7.4)中的代价函数,则有用训练样本{xi,di}i=1N的形式重申式(7.57),得:【6正则化参数估计】先考虑一个非线性回归问题,第i时间步的输入向量xi相对应的可观测输出yi定义为:如何选择...