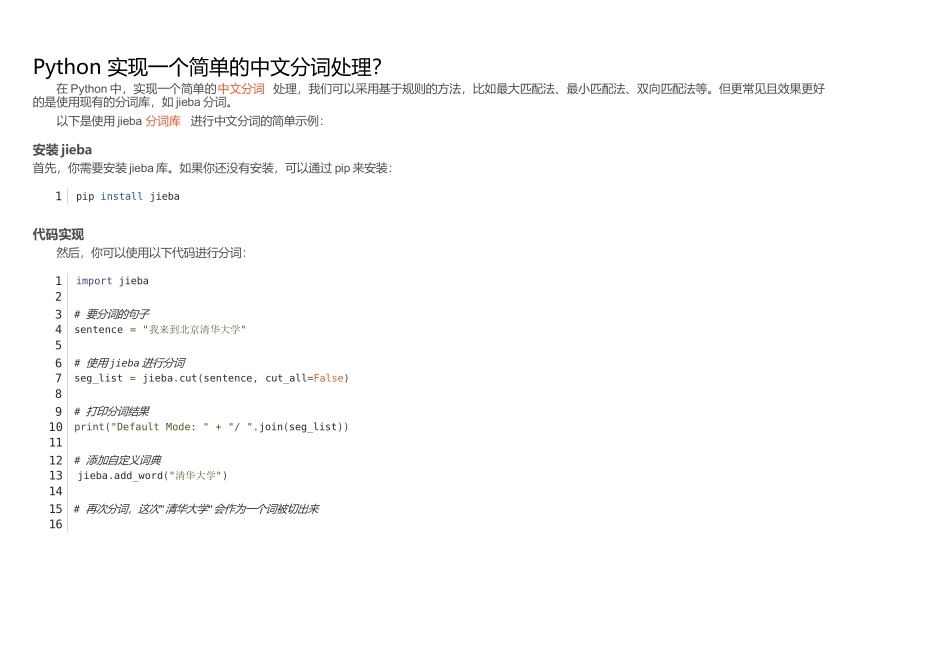

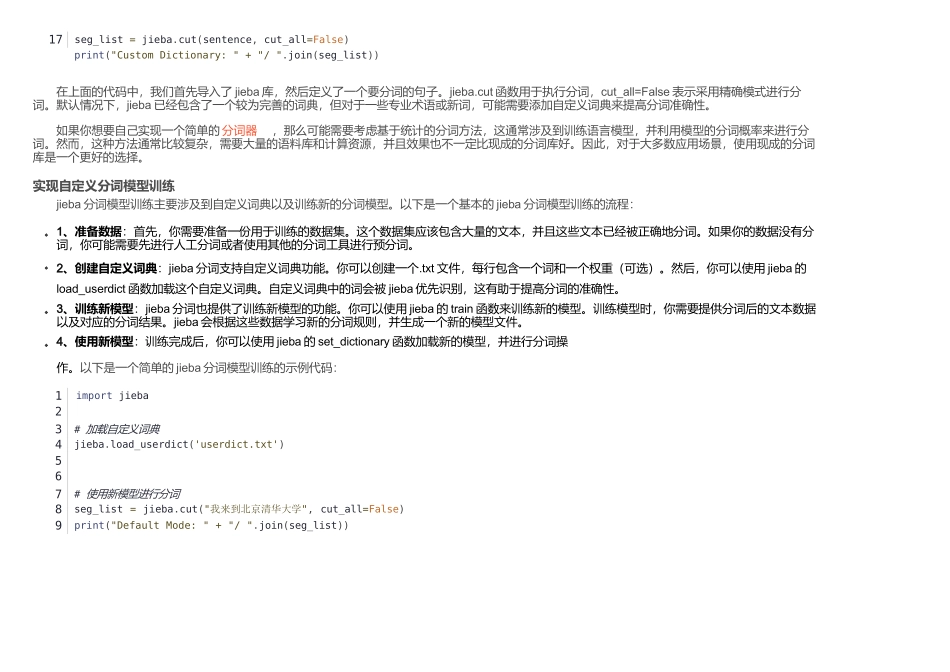

Python实现一个简单的中文分词处理?在Python中,实现一个简单的中文分词处理,我们可以采用基于规则的方法,比如最大匹配法、最小匹配法、双向匹配法等。但更常见且效果更好的是使用现有的分词库,如jieba分词。以下是使用jieba分词库进行中文分词的简单示例:安装jieba首先,你需要安装jieba库。如果你还没有安装,可以通过pip来安装:1pipinstalljieba代码实现然后,你可以使用以下代码进行分词:1importjieba23#要分词的句子4sentence="我来到北京清华大学"56#使用jieba进行分词7seg_list=jieba.cut(sentence,cut_all=False)89#打印分词结果10print("DefaultMode:"+"/".join(seg_list))1112#添加自定义词典13jieba.add_word("清华大学")1415#再次分词,这次"清华大学"会作为一个词被切出来1617seg_list=jieba.cut(sentence,cut_all=False)print("CustomDictionary:"+"/".join(seg_list))在上面的代码中,我们首先导入了jieba库,然后定义了一个要分词的句子。jieba.cut函数用于执行分词,cut_all=False表示采用精确模式进行分词。默认情况下,jieba已经包含了一个较为完善的词典,但对于一些专业术语或新词,可能需要添加自定义词典来提高分词准确性。如果你想要自己实现一个简单的分词器,那么可能需要考虑基于统计的分词方法,这通常涉及到训练语言模型,并利用模型的分词概率来进行分词。然而,这种方法通常比较复杂,需要大量的语料库和计算资源,并且效果也不一定比现成的分词库好。因此,对于大多数应用场景,使用现成的分词库是一个更好的选择。实现自定义分词模型训练jieba分词模型训练主要涉及到自定义词典以及训练新的分词模型。以下是一个基本的jieba分词模型训练的流程:1、准备数据:首先,你需要准备一份用于训练的数据集。这个数据集应该包含大量的文本,并且这些文本已经被正确地分词。如果你的数据没有分词,你可能需要先进行人工分词或者使用其他的分词工具进行预分词。2、创建自定义词典:jieba分词支持自定义词典功能。你可以创建一个.txt文件,每行包含一个词和一个权重(可选)。然后,你可以使用jieba的load_userdict函数加载这个自定义词典。自定义词典中的词会被jieba优先识别,这有助于提高分词的准确性。3、训练新模型:jieba分词也提供了训练新模型的功能。你可以使用jieba的train函数来训练新的模型。训练模型时,你需要提供分词后的文本数据以及对应的分词结果。jieba会根据这些数据学习新的分词规则,并生成一个新的模型文件。4、使用新模型:训练完成后,你可以使用jieba的set_dictionary函数加载新的模型,并进行分词操作。以下是一个简单的jieba分词模型训练的示例代码:1importjieba23#加载自定义词典4jieba.load_userdict('userdict.txt')567#使用新模型进行分词8seg_list=jieba.cut("我来到北京清华大学",cut_all=False)9print("DefaultMode:"+"/".join(seg_list))userdict.txt是jieba分词器的自定义词典文件,其中每一行包含一个词以及这个词的权重(可选)。权重用于在分词时调整这个词的出现频率,从而影响分词的结果。如果不指定权重,则默认为1。下面是一个userdict.txt的示例内容:1新词152新词23新词33在这个例子中:“新词1”的权重是5。“新词2”没有指定权重,所以权重默认为1。“新词3”的权重是3。权重越高,jieba在分词时越倾向于将这个词作为一个整体识别出来,而不是将其拆分成更小的词。注意,自定义词典中的词应该是不需要进行进一步分词的完整词汇。例如,如果你的文本中经常出现“机器学习”这个词,并且你希望jieba将其作为一个整体识别,那么你可以将“机器学习”添加到自定义词典中。当你使用jieba.load_userdict(‘userdict.txt’)加载这个自定义词典后,jieba在分词时会考虑这个词典中的词,从而可能改变默认的分词结果。请注意,上述代码中的train_data应该包含大量的训练数据,并且这些数据应该已经被正确地分词。此外,训练新的模型可能需要较长的时间,具体取决于训练数据的大小和复杂性。另外,jieba分词还支持多种分词模式,如精确模式、全模式和搜索引擎模式等。你可以根据实际需求选择合适的分词模式。同时,jieba分词也提供了词性标注功能,可以帮助你更好地理解文本的结构和语义。