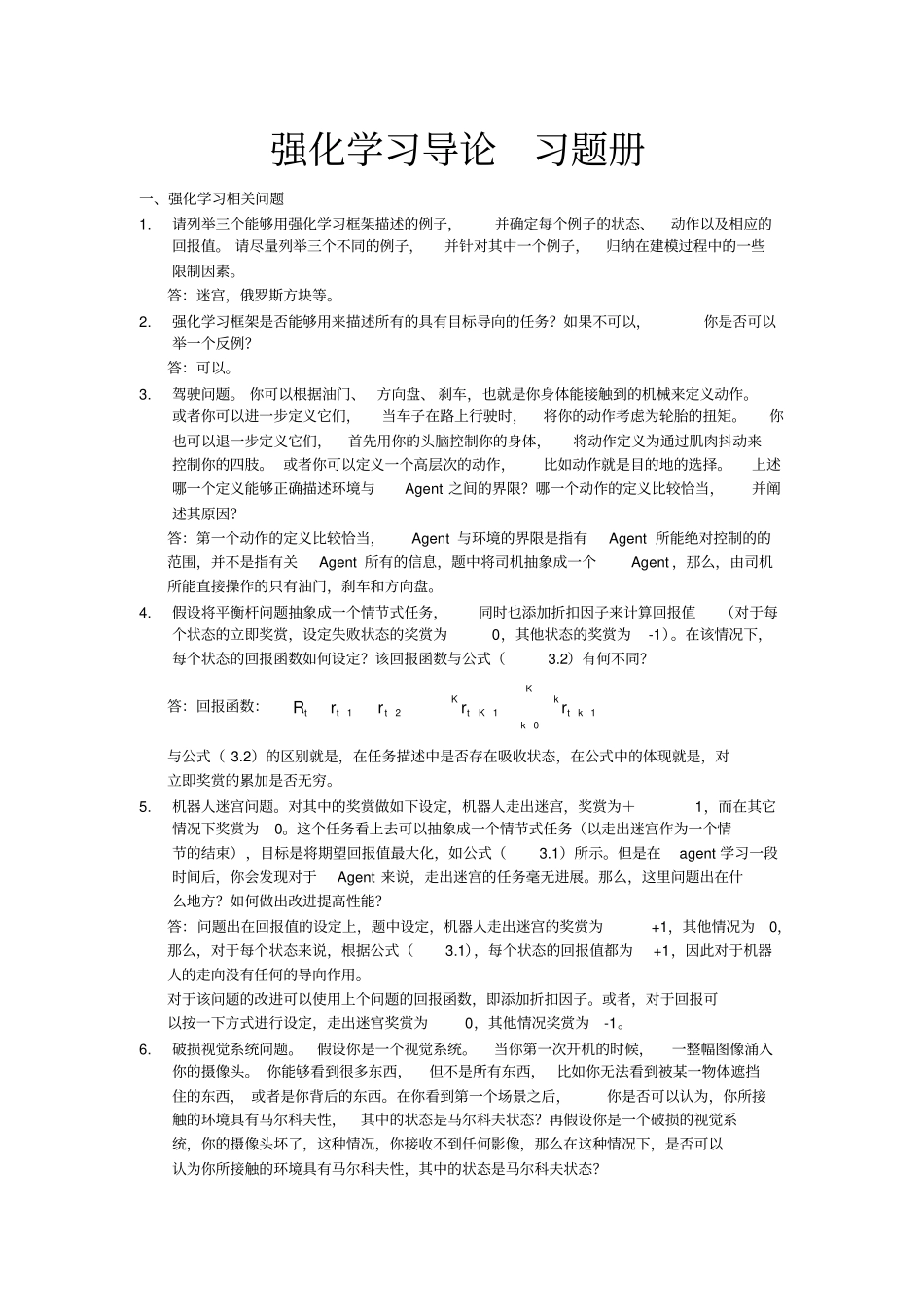

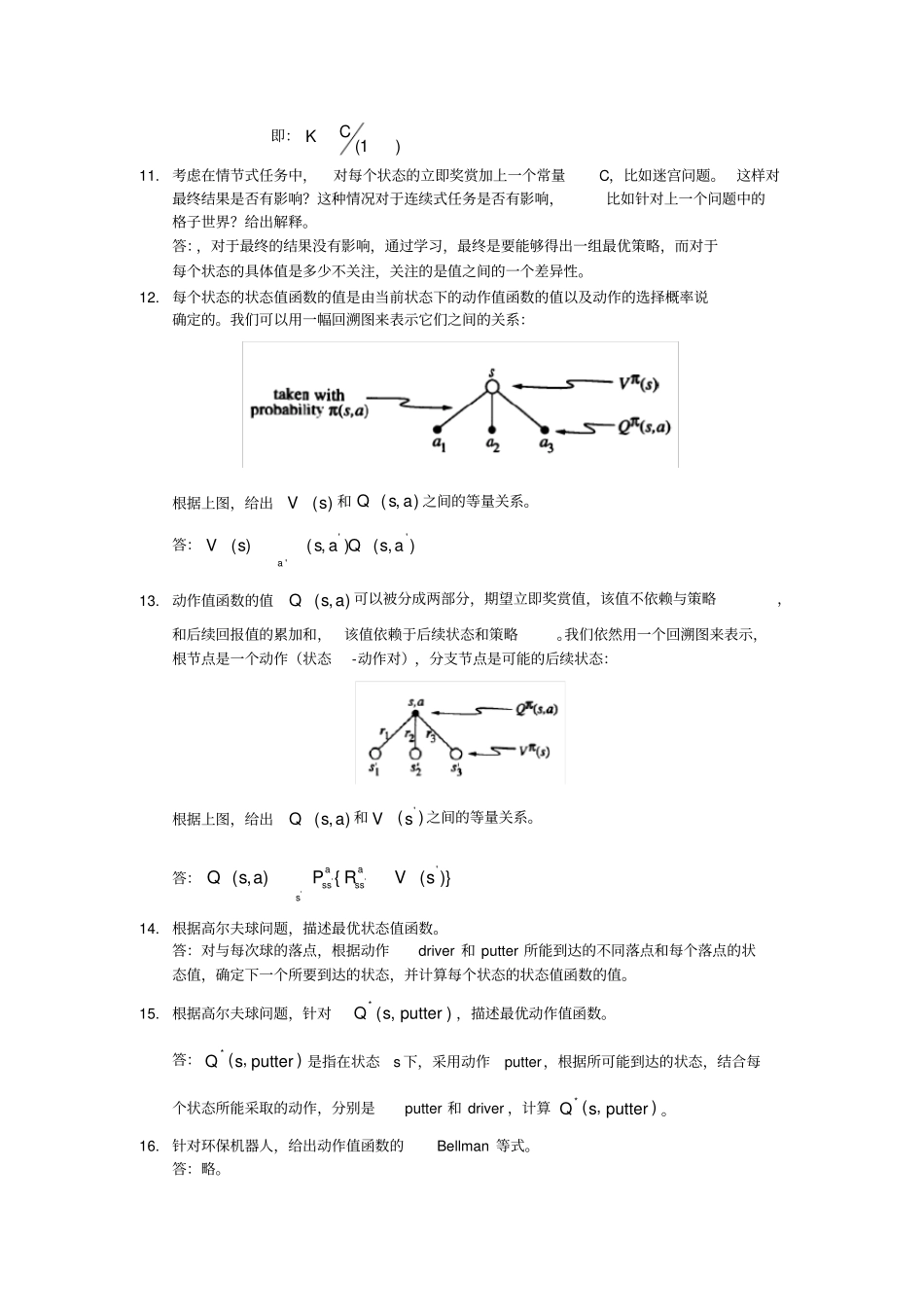

强化学习导论习题册一、强化学习相关问题1.请列举三个能够用强化学习框架描述的例子,并确定每个例子的状态、动作以及相应的回报值。 请尽量列举三个不同的例子,并针对其中一个例子,归纳在建模过程中的一些限制因素。答:迷宫,俄罗斯方块等。2.强化学习框架是否能够用来描述所有的具有目标导向的任务?如果不可以,你是否可以举一个反例?答:可以。3.驾驶问题。 你可以根据油门、 方向盘、 刹车,也就是你身体能接触到的机械来定义动作。或者你可以进一步定义它们,当车子在路上行驶时,将你的动作考虑为轮胎的扭矩。你也可以退一步定义它们,首先用你的头脑控制你的身体,将动作定义为通过肌肉抖动来控制你的四肢。 或者你可以定义一个高层次的动作,比如动作就是目的地的选择。上述哪一个定义能够正确描述环境与Agent 之间的界限?哪一个动作的定义比较恰当,并阐述其原因?答:第一个动作的定义比较恰当,Agent 与环境的界限是指有Agent 所能绝对控制的的范围,并不是指有关Agent 所有的信息,题中将司机抽象成一个Agent ,那么,由司机所能直接操作的只有油门,刹车和方向盘。4.假设将平衡杆问题抽象成一个情节式任务,同时也添加折扣因子来计算回报值(对于每个状态的立即奖赏,设定失败状态的奖赏为0,其他状态的奖赏为-1)。在该情况下,每个状态的回报函数如何设定?该回报函数与公式(3.2)有何不同?答:回报函数:KkktkKtKtttrrrrR01121与公式( 3.2)的区别就是,在任务描述中是否存在吸收状态,在公式中的体现就是,对立即奖赏的累加是否无穷。5.机器人迷宫问题。对其中的奖赏做如下设定,机器人走出迷宫,奖赏为+1,而在其它情况下奖赏为0。这个任务看上去可以抽象成一个情节式任务(以走出迷宫作为一个情节的结束),目标是将期望回报值最大化,如公式(3.1)所示。但是在agent 学习一段时间后,你会发现对于Agent 来说,走出迷宫的任务毫无进展。那么,这里问题出在什么地方?如何做出改进提高性能?答:问题出在回报值的设定上,题中设定,机器人走出迷宫的奖赏为+1,其他情况为0,那么,对于每个状态来说,根据公式(3.1),每个状态的回报值都为+1,因此对于机器人的走向没有任何的导向作用。对于该问题的改进可以使用上个问题的回报函数,即添加折扣因子。或者,对于回报可以按一下方式进行设定,走出迷宫奖赏为0,其他情况奖赏为-1。6.破损视觉系统问题。假设你是一个视觉系统。当你第一次开机的时候,一整...