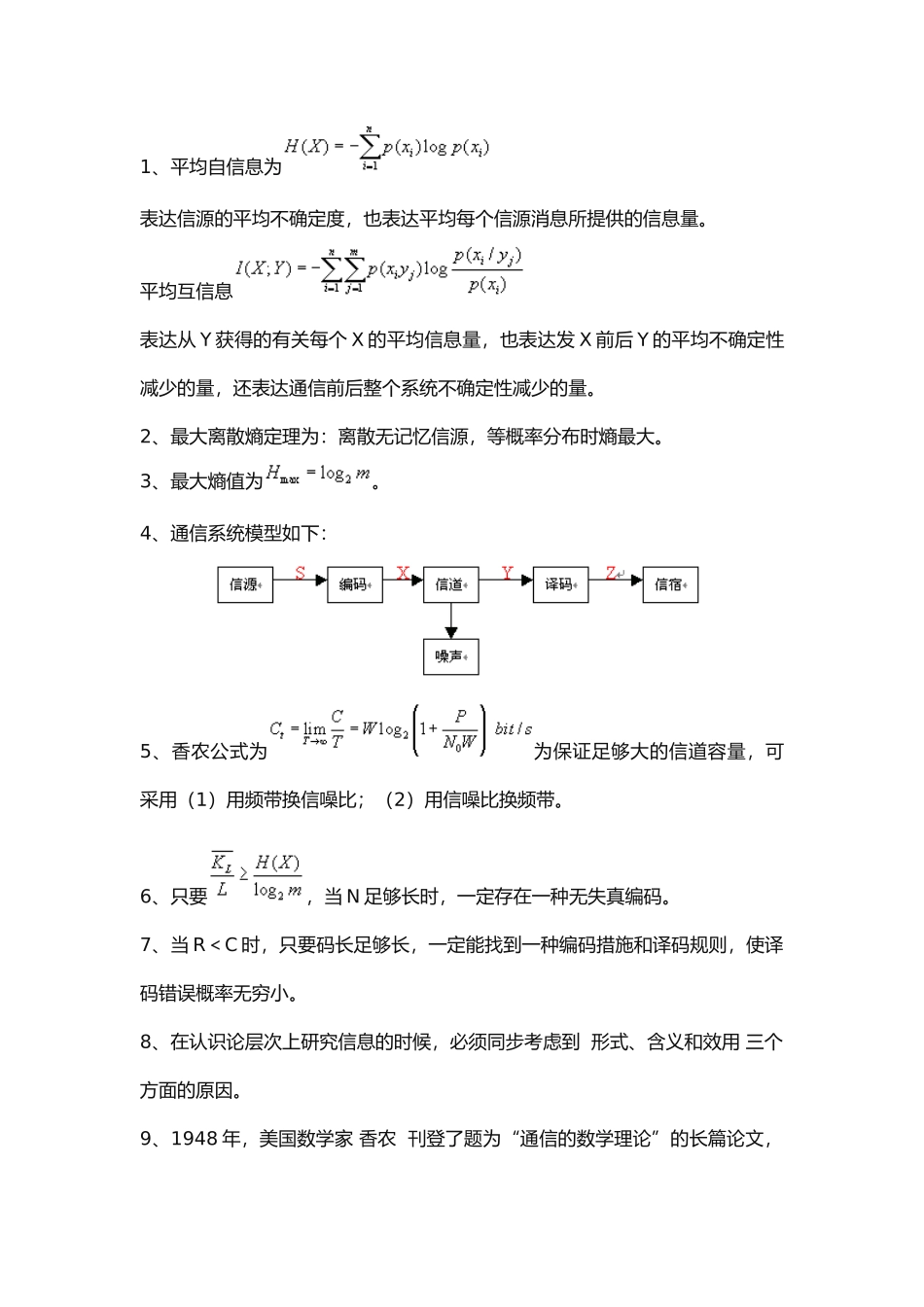

1、平均自信息为表达信源的平均不确定度,也表达平均每个信源消息所提供的信息量。平均互信息表达从 Y 获得的有关每个 X 的平均信息量,也表达发 X 前后 Y 的平均不确定性减少的量,还表达通信前后整个系统不确定性减少的量。2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。3、最大熵值为。4、通信系统模型如下: 5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。6、只要,当 N 足够长时,一定存在一种无失真编码。7、当 R<C 时,只要码长足够长,一定能找到一种编码措施和译码规则,使译码错误概率无穷小。8、在认识论层次上研究信息的时候,必须同步考虑到 形式、含义和效用 三个方面的原因。9、1948 年,美国数学家 香农 刊登了题为“通信的数学理论”的长篇论文,从而创立了信息论。按照信息的性质,可以把信息提成 语法信息、语义信息和语用信息 。按照信息的地位,可以把信息提成 客观信息和主观信息 。人们研究信息论的目的是为了 高效、可靠、安全 地互换和运用多种各样的信息。信息的 可度量性 是建立信息论的基础。记录度量 是信息度量最常用的措施。熵 是香农信息论最基本最重要的概念。事物的不确定度是用时间记录发生 概率的对数 来描述的。10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用 随机矢量 描述。11、一种随机事件发生某一成果后所带来的信息量称为自信息量,定义为 其发生概率对数的负值 。12、自信息量的单位一般有 比特、奈特和哈特 。13、必然事件的自信息是 0 。14、不也许事件的自信息量是 ∞ 。 15、两个互相独立的随机变量的联合自信息量等于 两个自信息量之和 。16、数据处理定理:当消息通过多级处理后,伴随处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。17、离散平稳无记忆信源 X 的 N 次扩展信源的熵等于离散信源 X 的熵的 N 倍 。 18、离散平稳有记忆信源的极限熵,。19、对于 n 元 m 阶马尔可夫信源,其状态空间共有 nm 个不一样的状态。20、一维持续随即变量 X 在[a,b]区间内均匀分布时,其信源熵为 log2(b-a) 。21、平均功率为 P 的高斯分布的持续信源,其信源熵,Hc(X)=。22、对于限峰值功率的 N 维持续信源,当概率密度 均匀分布 时持续信源熵具有最大值。23、对于限平均功率的一维持续信源,当概率密度 高斯分布 时,信源熵...