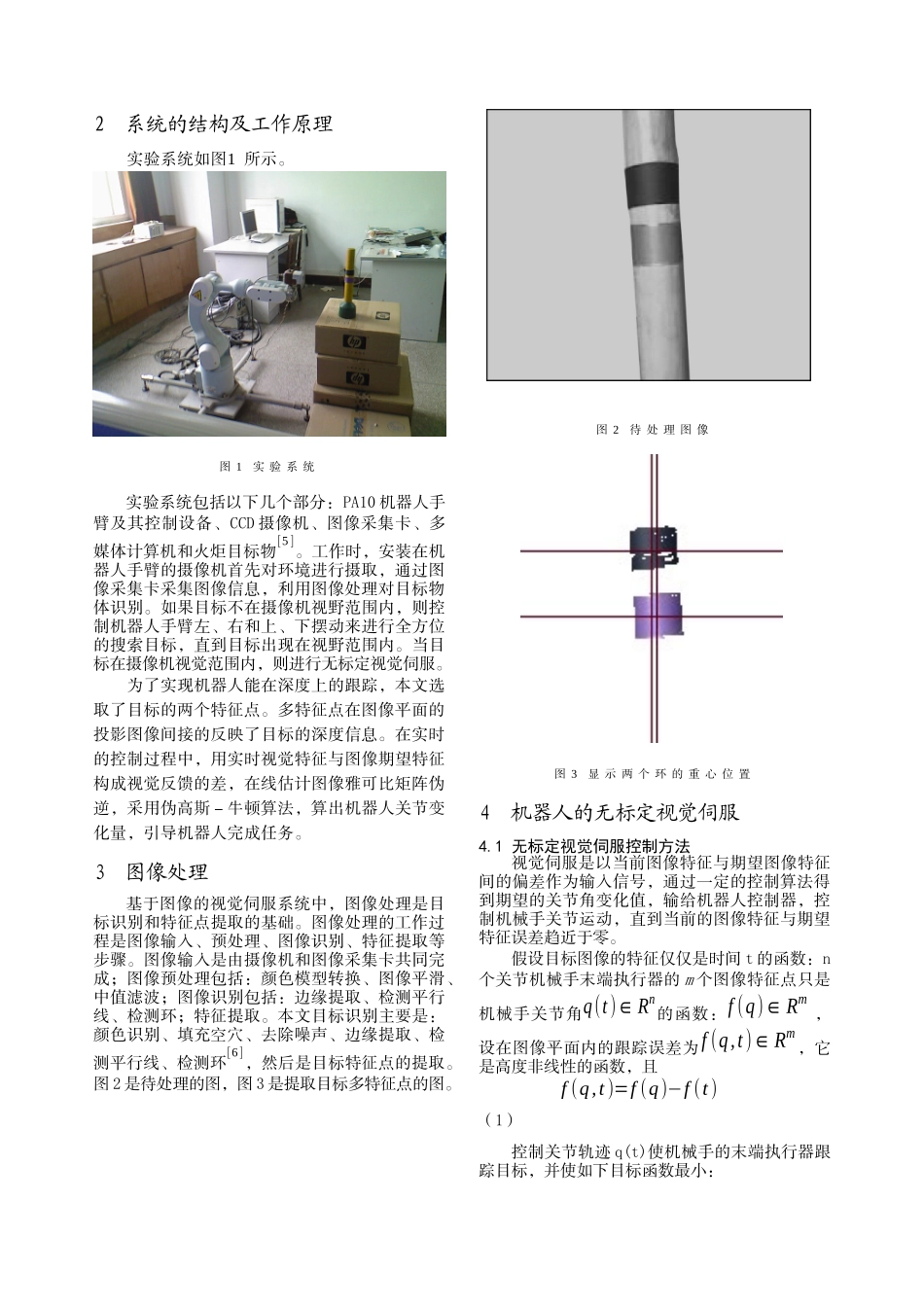

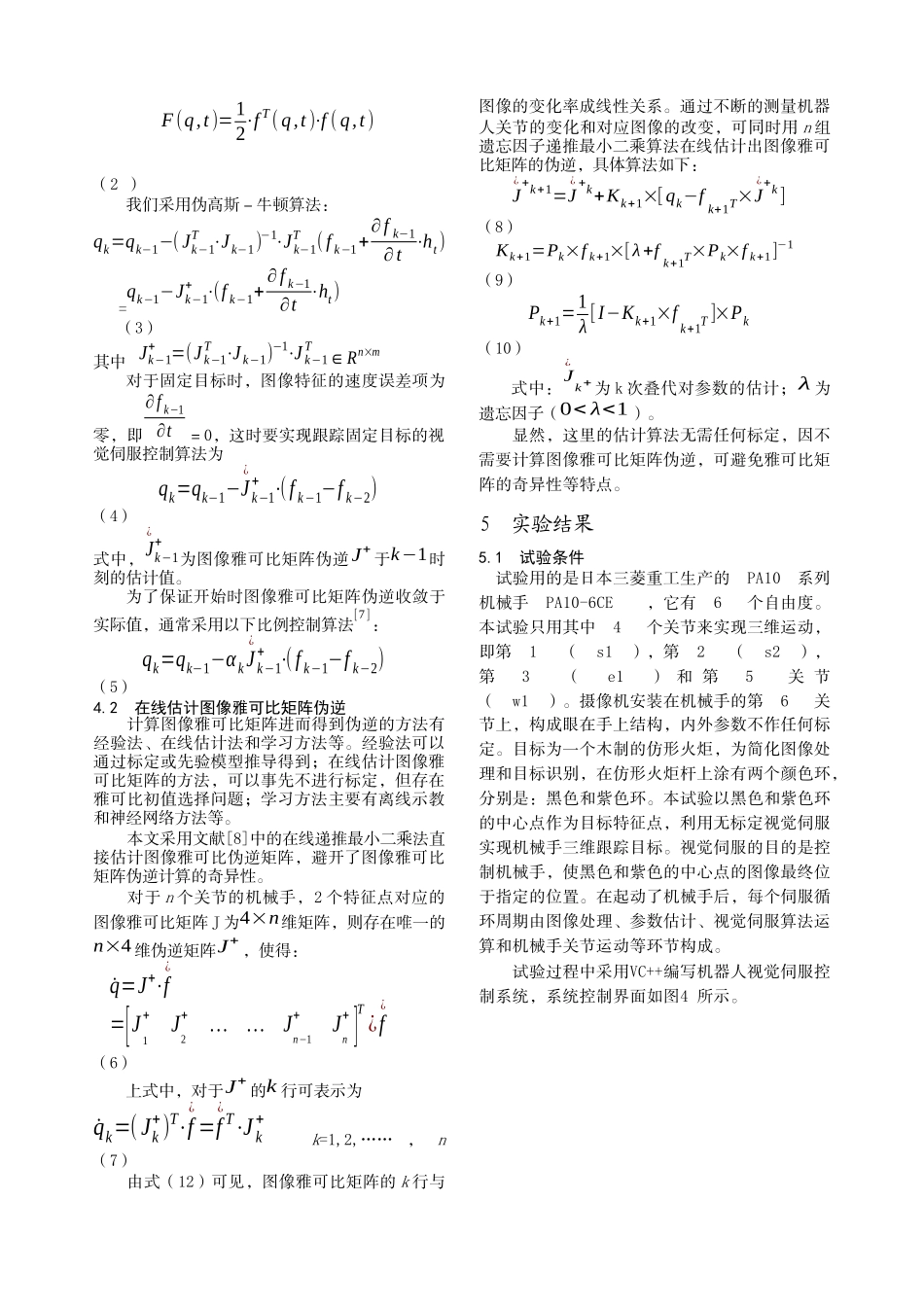

无标定视觉伺服在机器人跟踪多特征点目标的应用宋平康庆生孟正大东南大学摘要:介绍了一种眼在手上的机器人3D视觉跟踪多特征点目标的无标定视觉伺服。利用基于递推最小二乘法估计图像雅可比矩阵伪逆的无标定视觉伺服,这种方法无需计算雅可比矩阵伪逆,避开了图像雅可比矩阵伪逆计算的奇异性问题。实验结果验证了这种方法的可行性,为机器人抓取目标打下了基础。关键词:眼在手上多特征点无标定视觉伺服3D视觉跟踪ApplicationofUn-calibratedVisualServoinTrackingMulti-featureObjectSongPingKangQingshengMengZhengdaAbstract:Thispaperpresentsanuncalibratedcontrolmethodforroboticvision-guidedtargets3Dtrackingusinganeye-in-handcamera.TheuncalibratedvisualservoingisadoptedtofulfilltheonlinerecursiveestimationofimageJacobianpseudo-inversematrix,Thismethoddoesn’tcomputethemoore-PenroseinverseofimageJacobianandavoidthesingularityofimageJacobian.Thisexperiamentalresultsdemonstratethefeasibilityofthismethodandexperimentlaysthegroundworkforgraspingtarget.Keywords:eye-in-handfeaturepointsuncalibratedvisualservoing3Dvisualtracking1引言近年来,越来越多的机器人被用于工业生产其领域主要有机器人焊接、工件装配等。这些任务需要机器人有视觉功能,并将视觉信息加入到机器人控制中,其方法被称为视觉伺服。传统的基于视觉的机器人控制,要求摄像机内部参数标定、机器人运动学标定、手眼关系标定[1],但在实际情况中无法精确标定。为了克服基于标定的方法的弊端,一种无标定方法就越来越受到关注。它的核心是在手眼关系及摄像机模型未知的条件下,在线估计图像雅可比矩阵,并利用视觉反馈误差控制机器人运动,进而完成视觉伺服[2]。由于视觉传感本身固有的特点只能反馈两维信息,于是就始终存在着对深度信息的估计问题,如何实时而准确地获取深度信息是急需解决的关键而困难的问题[3]。目前获取目标三维信息的主要有以下几种方法:1)立体视觉,其主要特点是能够获得景深,但立体视觉要进行对应点的匹配,耗费大量的机时,难以满足实时性的要求;2)主动视觉,它通过测距传感器直接测出目标物体的距离,但这就涉及到多传感器的数据融合问题;3)单目视觉,它是通过运动获取深度和从散焦获取深度等[4]。本文主要用单目视觉来进行无标定视觉伺服,根据目标多特征点在图像平面成像的位置与摄像机的相对位置相关间接反映目标深度信息,由视觉伺服跟踪目标。2系统的结构及工作原理实验系统如图1所示。图1实验系统实验系统包括以下几个部分:PA10机器人手臂及其控制设备、CCD摄像机、图像采集卡、多媒体计算机和火炬目标物[5]。工作时,安装在机器人手臂的摄像机首先对环境进行摄取,通过图像采集卡采集图像信息,利用图像处理对目标物体识别。如果目标不在摄像机视野范围内,则控制机器人手臂左、右和上、下摆动来进行全方位的搜索目标,直到目标出现在视野范围内。当目标在摄像机视觉范围内,则进行无标定视觉伺服。为了实现机器人能在深度上的跟踪,本文选取了目标的两个特征点。多特征点在图像平面的投影图像间接的反映了目标的深度信息。在实时的控制过程中,用实时视觉特征与图像期望特征构成视觉反馈的差,在线估计图像雅可比矩阵伪逆,采用伪高斯-牛顿算法,算出机器人关节变化量,引导机器人完成任务。3图像处理基于图像的视觉伺服系统中,图像处理是目标识别和特征点提取的基础。图像处理的工作过程是图像输入、预处理、图像识别、特征提取等步骤。图像输入是由摄像机和图像采集卡共同完成;图像预处理包括:颜色模型转换、图像平滑、中值滤波;图像识别包括:边缘提取、检测平行线、检测环;特征提取。本文目标识别主要是:颜色识别、填充空穴、去除噪声、边缘提取、检测平行线、检测环[6],然后是目标特征点的提取。图2是待处理的图,图3是提取目标多特征点的图。图2待处理图像图3显示两个环的重心位置4机器人的无标定视觉伺服4.1无标定视觉伺服控制方法视觉伺服是以当前图像特征与期望图像特征间的偏差作为输入信号,通过一定的控制...