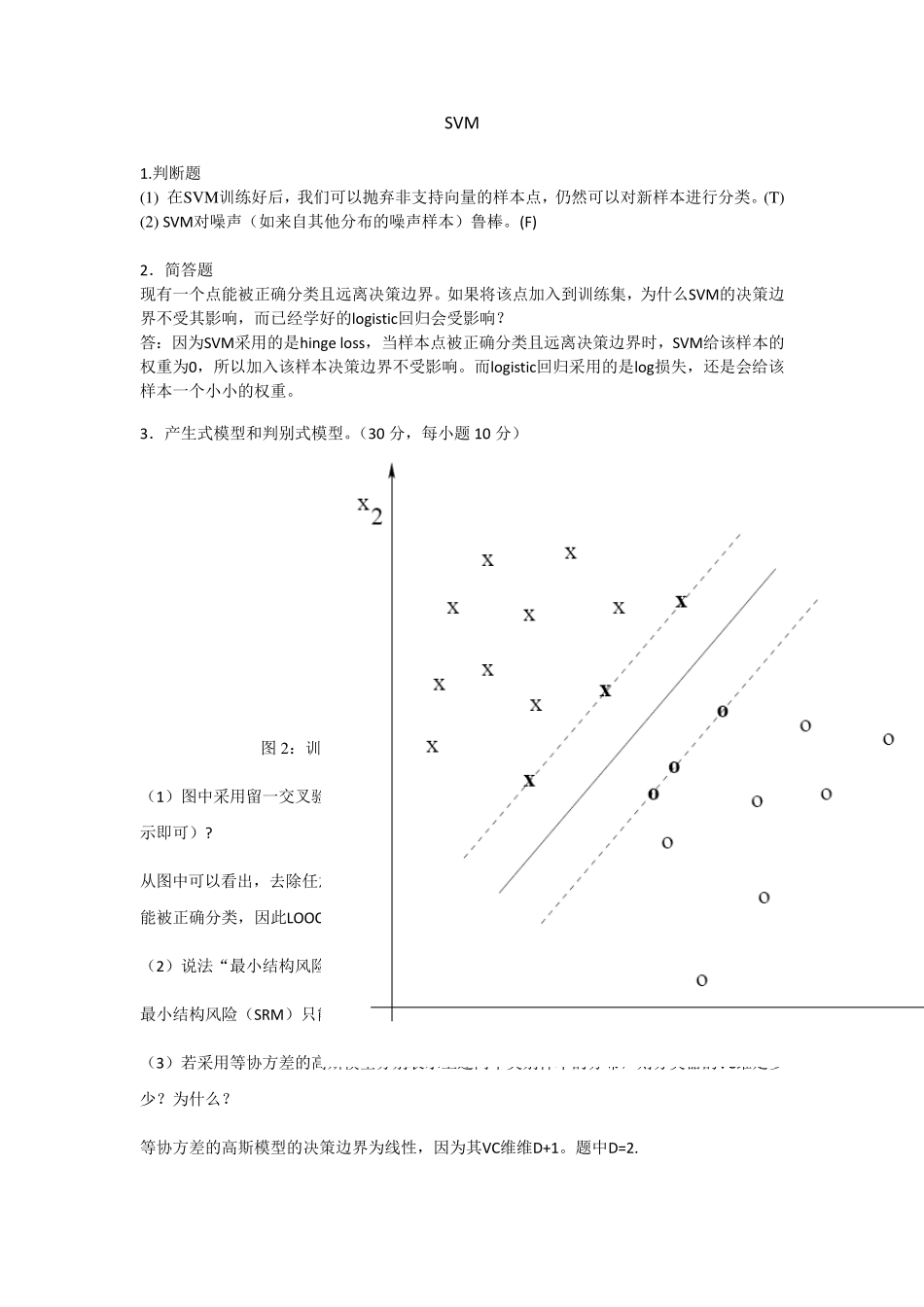

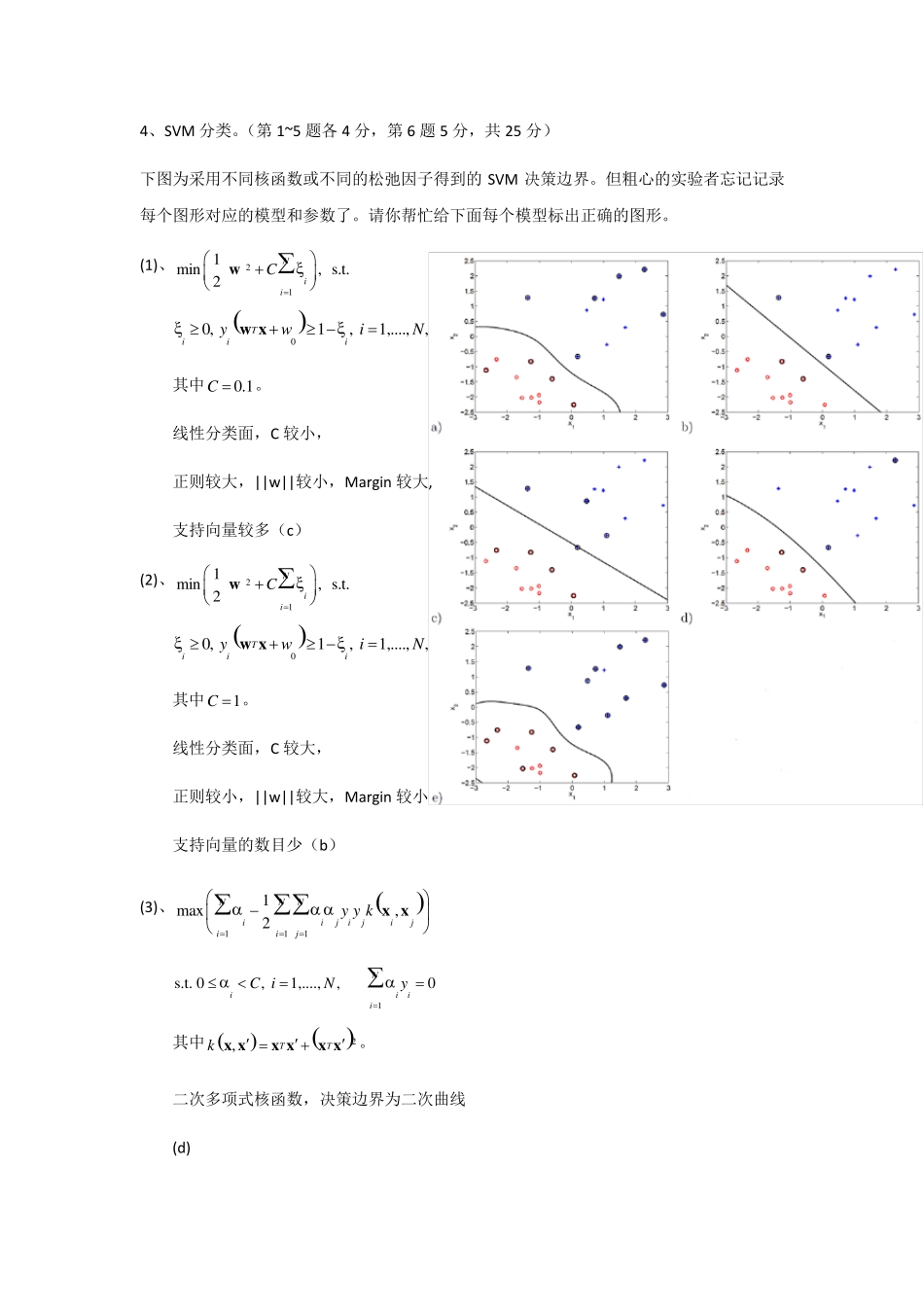

SVM 1.判断题 (1) 在SVM训练好后,我们可以抛弃非支持向量的样本点,仍然可以对新样本进行分类。(T) (2) SVM对噪声(如来自其他分布的噪声样本)鲁棒。(F) 2.简答题 现有一个点能被正确分类且远离决策边界。如果将该点加入到训练集,为什么SVM的决策边界不受其影响,而已经学好的logistic回归会受影响? 答:因为SVM采用的是hinge loss,当样本点被正确分类且远离决策边界时,SVM给该样本的权重为0,所以加入该样本决策边界不受影响。而logistic回归采用的是log损失,还是会给该样本一个小小的权重。 3.产生式模型和判别式模型。(30 分,每小题 10 分) 图 2:训练集、最大间隔线性分类器和支持向量(粗体) (1)图中采用留一交叉验证得到的最大间隔分类器的预测误差的估计是多少(用样本数表示即可)? 从图中可以看出,去除任意点都不影响SVM的分界面。而保留所有样本时,所有的样本点都能被正确分类,因此LOOCV的误差估计为0。 (2)说法“最小结构风险保证会找到最低决策误差的模型”是否正确,并说明理由。(F) 最小结构风险(SRM)只能保证在所有考虑的模型中找到期望风险上界最小的模型。 (3)若采用等协方差的高斯模型分别表示上述两个类别样本的分布,则分类器的VC维是多少?为什么? 等协方差的高斯模型的决策边界为线性,因为其VC维维D+1。题中D=2. 4、SVM 分类。(第 1~5 题各 4 分,第 6 题 5 分,共 25 分) 下图为采用不同核函数或不同的松弛因子得到的 SVM 决策边界。但粗心的实验者忘记记录每个图形对应的模型和参数了。请你帮忙给下面每个模型标出正确的图形。 (1)、211min, s.t.2NiiCw 00, 1, 1,....,, TiiiywiN w x 其中0.1C 。 线性分类面,C 较小, 正则较大,||w||较小,Margin 较大, 支持向量较多(c) (2)、211min, s.t.2NiiCw 00, 1, 1,....,, TiiiywiN w x 其中1C 。 线性分类面,C 较大, 正则较小,||w||较大,Margin 较小 支持向量的数目少(b) (3)、1111max,2NNNiijijijiijyykx x 1s.t. 0, 1,....,, 0NiiiiC iNy 其中 2,TTkx xx xx x。 二次多项式核函数,决策边界为二次曲线 (d) (4)、1111max,2NNNiijijijiijyykx x 1s...