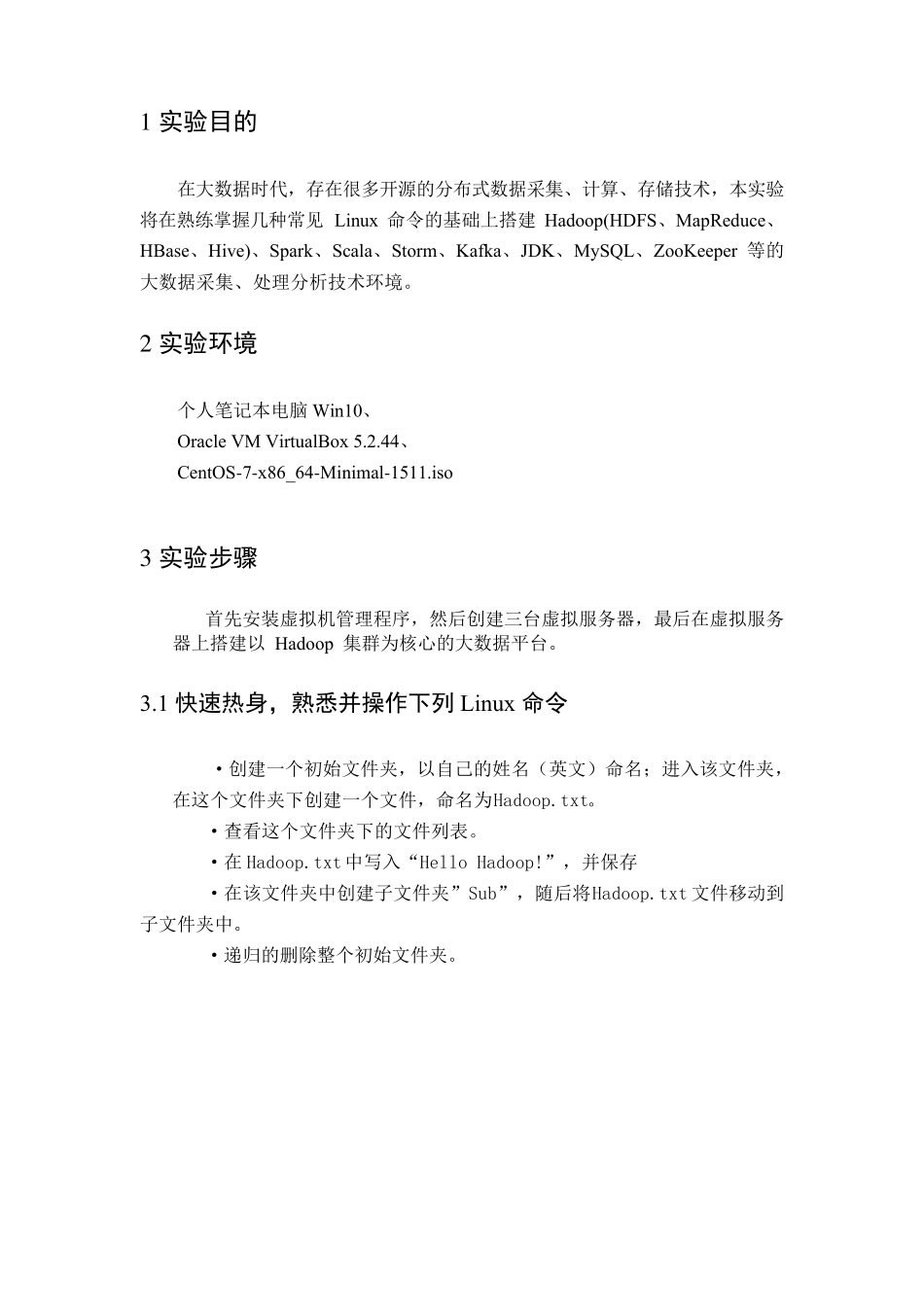

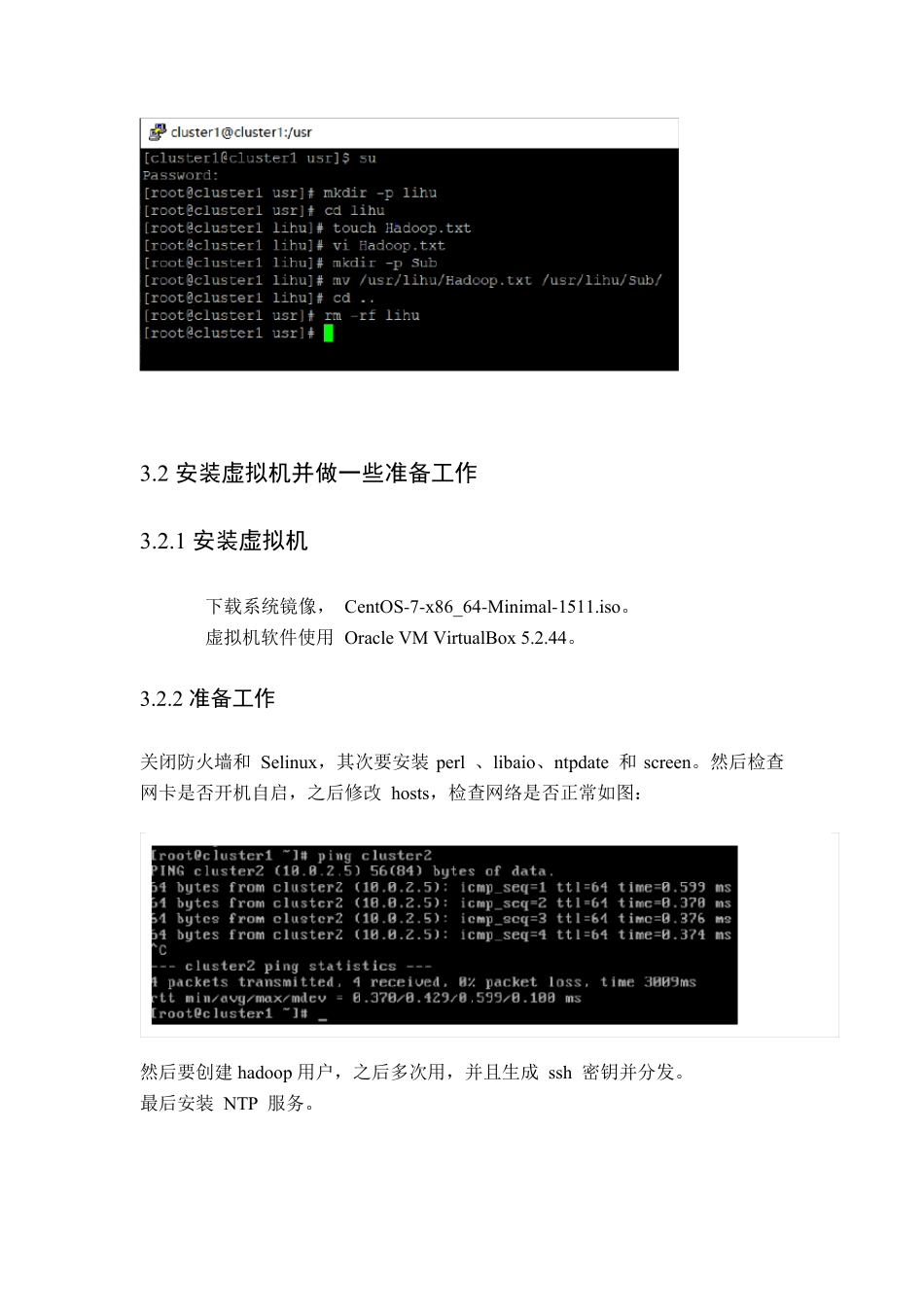

大数据技术实验报告 大数据技术实验一 Hadoop 大数据平台安装实验 1 实验目的 在大数据时代,存在很多开源的分布式数据采集、计算、存储技术,本实验将在熟练掌握几种常见Linux 命令的基础上搭建Hadoop(HDFS、MapReduce、HBase、Hiv e)、Spark、Scala、Storm、Kafka、JDK、My SQL、ZooKeeper 等的大数据采集、处理分析技术环境。 2 实验环境 个人笔记本电脑Win10、 Oracle VM VirtualBox 5.2.44、 CentOS-7-x 86_64-Minimal-1511.iso 3 实验步骤 首先安装虚拟机管理程序,然后创建三台虚拟服务器,最后在虚拟服务器上搭建以 Hadoop 集群为核心的大数据平台。 3.1 快速热身,熟悉并操作下列Linux 命令 ·创建一个初始文件夹,以自己的姓名(英文)命名;进入该文件夹,在这个文件夹下创建一个文件,命名为Hadoop.txt。 ·查看这个文件夹下的文件列表。 ·在Hadoop.txt 中写入“Hello Hadoop!”,并保存 ·在该文件夹中创建子文件夹”Sub”,随后将Hadoop.txt 文件移动到子文件夹中。 ·递归的删除整个初始文件夹。 3.2 安装虚拟机并做一些准备工作 3.2.1 安装虚拟机 下载系统镜像, CentOS-7-x 86_64-Minimal-1511.iso。 虚拟机软件使用 Oracle VM VirtualBox 5.2.44。 3.2.2 准备工作 关闭防火墙和 Selinux ,其次要安装perl 、libaio、ntpdate 和screen。然后检查网卡是否开机自启,之后修改 hosts,检查网络是否正常如图: 然后要创建hadoop 用户,之后多次用,并且生成 ssh 密钥并分发。 最后安装 NTP 服务。 3.3 安装MYSQL 3.3.1 安装 3.3.2 测试 3.4 安装JDK。 3.4 安装ZooKeeper。 3.5 安装kafka。 3.6 安装 Hado o p 3.7 安装HBase 3.8 安装Hive 3.9 安装Scala 3.10 安装 Spark 3.11 安装Storm 4 所遇到的问题及解决方式。 4.1 文件传输问题。 再用FilZilla 传文件时,出现下图情况: 通过查阅网络资料,最终知道需要修改为关于ssh 的协议 4.2 virtalBox 版本问题 文件中提供的老板在win10 上并不能用,刚开始下载的最新版,但没找到设置only-host 网络地方,经过查找,最终确定用5.2.44。 4.3 Permission Denied 问题。 在操作过程中由于root 和hadoop 用户来回切换,是不是就会出现hadoop用户不能操作一些文件。通过报错中的提示,找到文件名,由于路径太长,报错日志中并不会给全路径,可以先用find / -name 查找到...