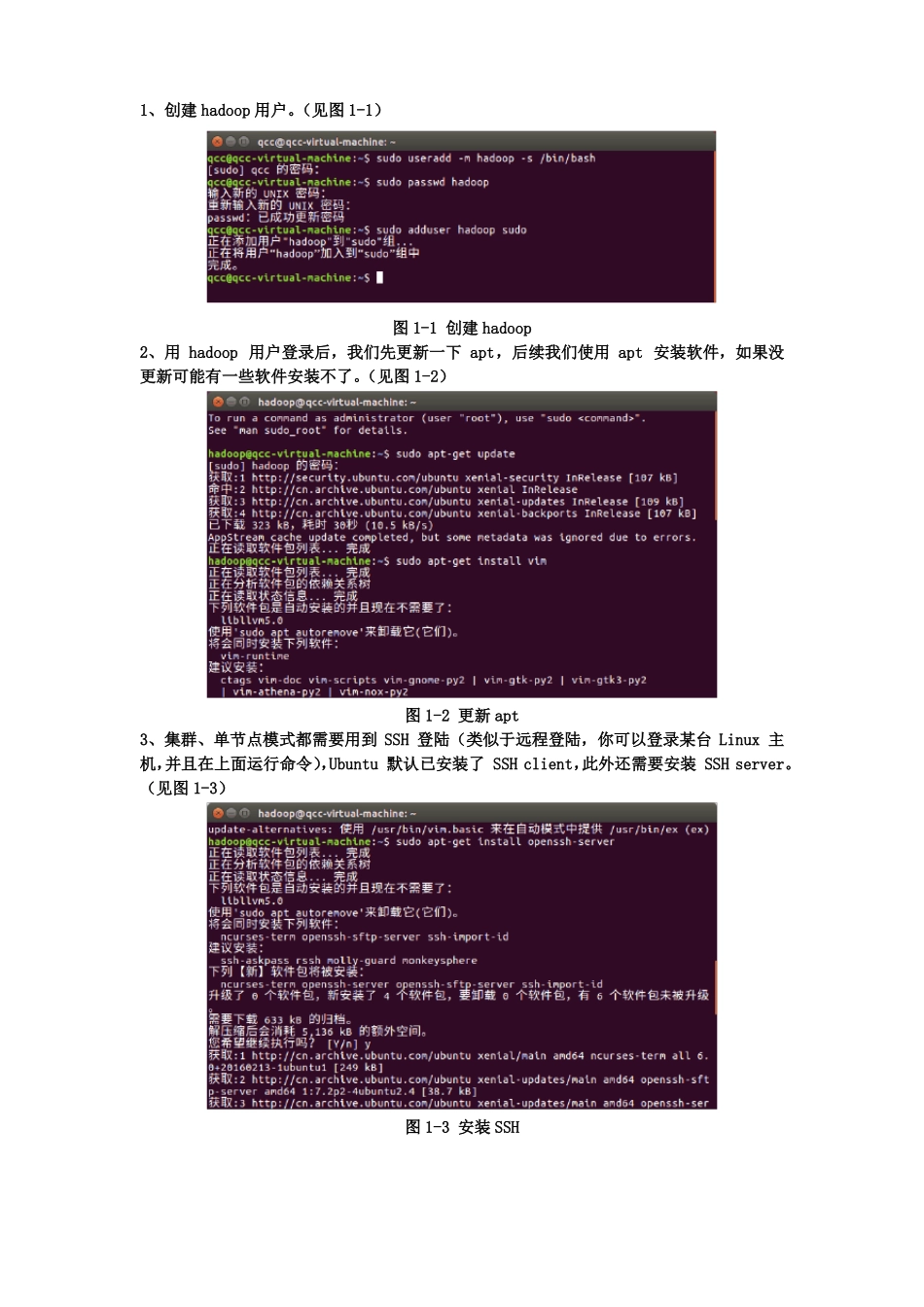

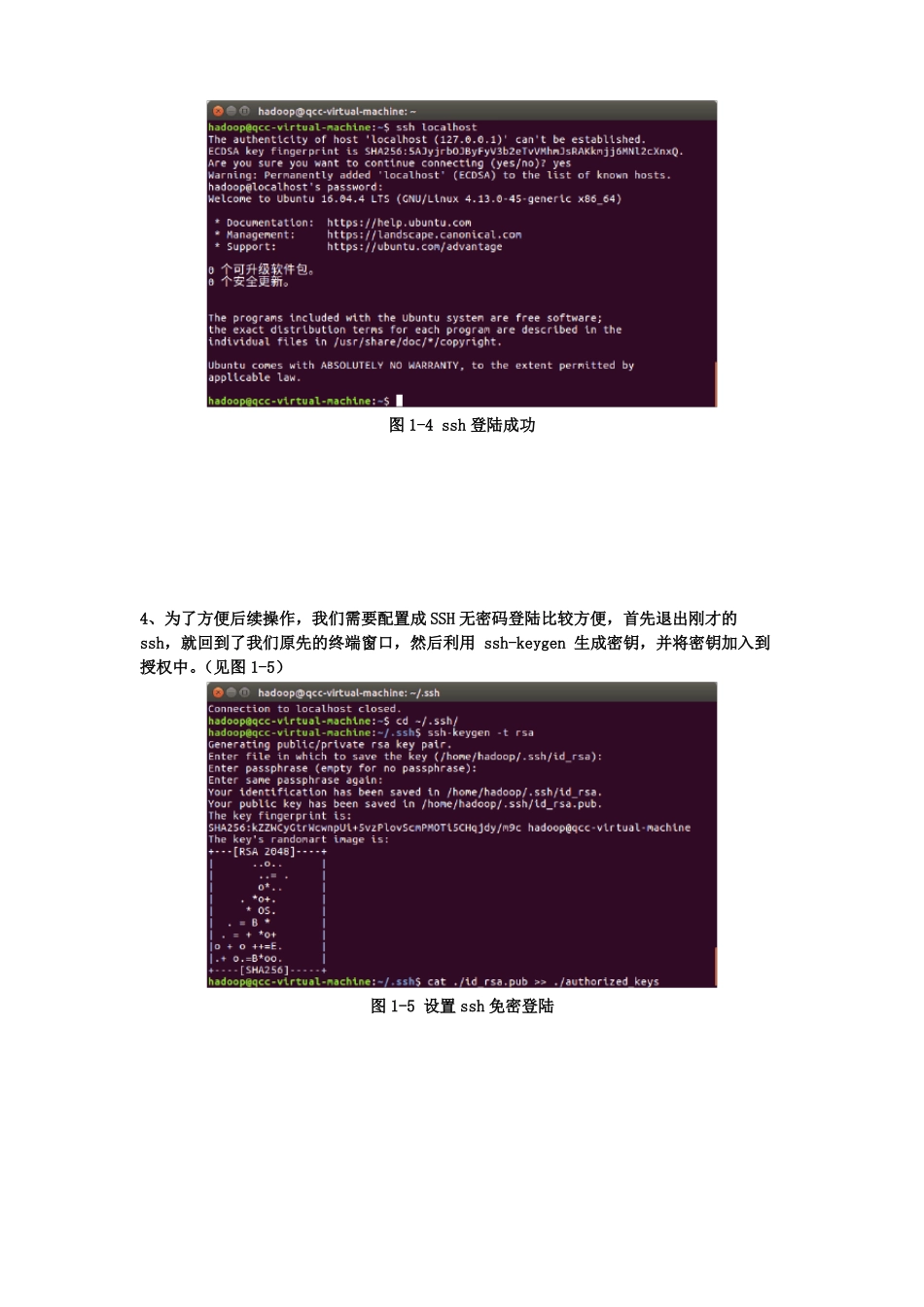

1、创建 hadoop 用户。(见图 1-1)图 1-1 创建 hadoop2、用 hadoop 用户登录后,我们先更新一下 apt,后续我们使用 apt 安装软件,如果没更新可能有一些软件安装不了。(见图 1-2)图 1-2 更新 apt3、集群、单节点模式都需要用到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上面运行命令),Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server。(见图 1-3)图 1-3 安装 SSH图 1-4 ssh 登陆成功4、为了方便后续操作,我们需要配置成 SSH 无密码登陆比较方便,首先退出刚才的ssh,就回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中。(见图 1-5)图 1-5 设置 ssh 免密登陆图 1-6 ssh 免密登陆成功5、联网安装 java 环境图 1-7 联网安装 jdk,jre图 1-8 配置 jdk 路径图 1-9 java 环境成功配置6、安装 hadoop2图 1-10 hadoop2.7.1 安装成功图 1-11hadoop 的伪分布配置图 1-12 NameNode 的格式化成功图 1-13 hadoop 启动成功图 1-14 web 页面管理7、spark 平台安装与配置图 1-15 spark 的安装图 1-16 spark 环境配置图 1-17 验证 spark 安装成功