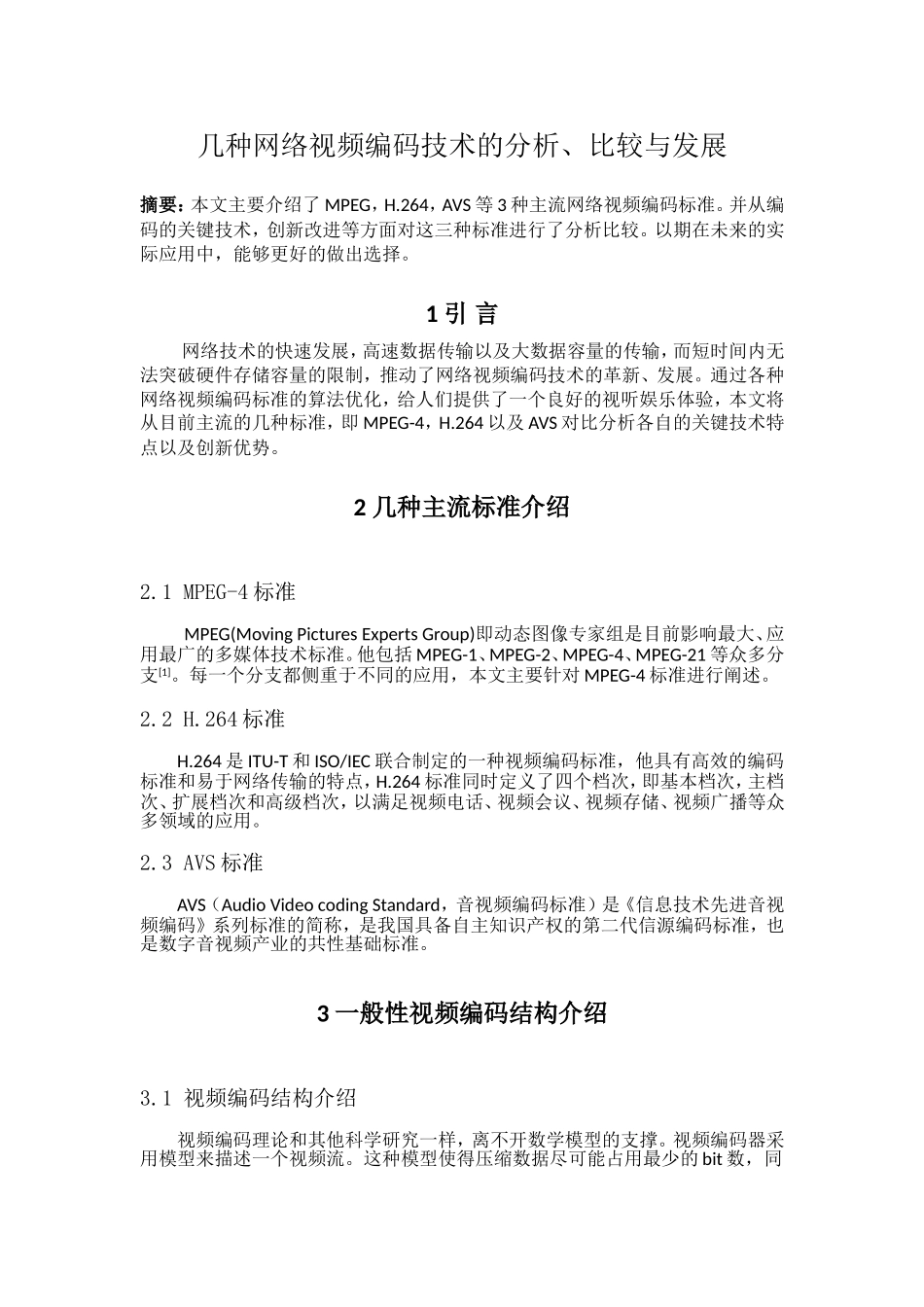

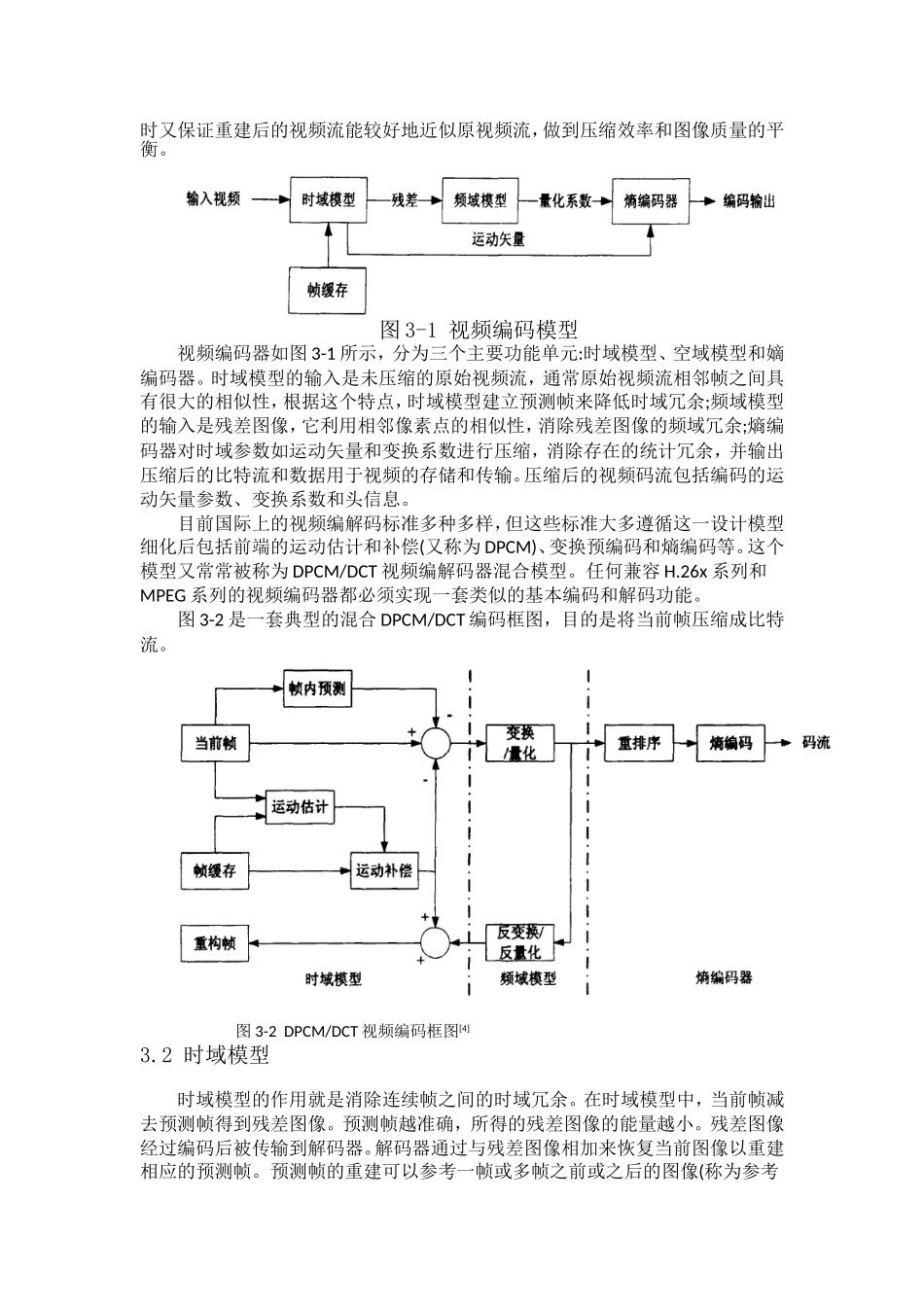

几种网络视频编码技术的分析、比较与发展摘要:本文主要介绍了MPEG,H.264,AVS等3种主流网络视频编码标准。并从编码的关键技术,创新改进等方面对这三种标准进行了分析比较。以期在未来的实际应用中,能够更好的做出选择。1引言网络技术的快速发展,高速数据传输以及大数据容量的传输,而短时间内无法突破硬件存储容量的限制,推动了网络视频编码技术的革新、发展。通过各种网络视频编码标准的算法优化,给人们提供了一个良好的视听娱乐体验,本文将从目前主流的几种标准,即MPEG-4,H.264以及AVS对比分析各自的关键技术特点以及创新优势。2几种主流标准介绍2.1MPEG-4标准MPEG(MovingPicturesExpertsGroup)即动态图像专家组是目前影响最大、应用最广的多媒体技术标准。他包括MPEG-1、MPEG-2、MPEG-4、MPEG-21等众多分支[1]。每一个分支都侧重于不同的应用,本文主要针对MPEG-4标准进行阐述。2.2H.264标准H.264是ITU-T和ISO/IEC联合制定的一种视频编码标准,他具有高效的编码标准和易于网络传输的特点,H.264标准同时定义了四个档次,即基本档次,主档次、扩展档次和高级档次,以满足视频电话、视频会议、视频存储、视频广播等众多领域的应用。2.3AVS标准AVS(AudioVideocodingStandard,音视频编码标准)是《信息技术先进音视频编码》系列标准的简称,是我国具备自主知识产权的第二代信源编码标准,也是数字音视频产业的共性基础标准。3一般性视频编码结构介绍3.1视频编码结构介绍视频编码理论和其他科学研究一样,离不开数学模型的支撑。视频编码器采用模型来描述一个视频流。这种模型使得压缩数据尽可能占用最少的bit数,同时又保证重建后的视频流能较好地近似原视频流,做到压缩效率和图像质量的平衡。图3-1视频编码模型视频编码器如图3-1所示,分为三个主要功能单元:时域模型、空域模型和嫡编码器。时域模型的输入是未压缩的原始视频流,通常原始视频流相邻帧之间具有很大的相似性,根据这个特点,时域模型建立预测帧来降低时域冗余;频域模型的输入是残差图像,它利用相邻像素点的相似性,消除残差图像的频域冗余;熵编码器对时域参数如运动矢量和变换系数进行压缩,消除存在的统计冗余,并输出压缩后的比特流和数据用于视频的存储和传输。压缩后的视频码流包括编码的运动矢量参数、变换系数和头信息。目前国际上的视频编解码标准多种多样,但这些标准大多遵循这一设计模型细化后包括前端的运动估计和补偿(又称为DPCM)、变换预编码和熵编码等。这个模型又常常被称为DPCM/DCT视频编解码器混合模型。任何兼容H.26x系列和MPEG系列的视频编码器都必须实现一套类似的基本编码和解码功能。图3-2是一套典型的混合DPCM/DCT编码框图,目的是将当前帧压缩成比特流。图3-2DPCM/DCT视频编码框图[4]3.2时域模型时域模型的作用就是消除连续帧之间的时域冗余。在时域模型中,当前帧减去预测帧得到残差图像。预测帧越准确,所得的残差图像的能量越小。残差图像经过编码后被传输到解码器。解码器通过与残差图像相加来恢复当前图像以重建相应的预测帧。预测帧的重建可以参考一帧或多帧之前或之后的图像(称为参考帧),其精度可以通过参考帧和当前帧之间的运动补偿来提高。对于运动图像为了使预测误差尽可能小,从而达到减少码率的目的,就一定要采用适当的预测方法,这个方法就是运动补偿预测。运动补偿预测有两个过程第一个过程是对运动物体的位移做出估计,即运动物体从上一帧到当前帧位移的方向和像素数要做出估计,也就是要求出运动矢量,这个过程叫做运动估计。第二个过程是按照运动矢量,将上一帧做位移,求出对当前帧的估计,这个过程称为运动补偿。图像分割是运动补偿预测的基础。理想上是将图像分割成不同运动的物体,但实现比较困难,所以通常采用两种较简单的方法。一种方法是对每个像素的位移进行递归估计;另一种是把图像分为矩形子块,适当选择块的大小,估计出运动子块的位移,进行预测传输。得到运动物体的位移估值后,即可将其送入预测器。与图像分割的两种方法相对应,运动估计有两种方法:一个是以像素为基础的运动估计算法,也就是对每一个像素做估计,实现较为复杂;另一个是以...